大语言模型(Large Language Models, LLMs)在面对专业领域知识问题的时候,经常会生成偏离既定事实的回复,或模糊不清的回答,从而带来了潜在应用风险。

检索增强生成(Retrieval-Augmented Generation, RAG)通过构建特定领域知识库,采用基于向量的检索技术来提取与给定查询相关的信息,从而使LLM能够生成更准确、更可靠的内容。

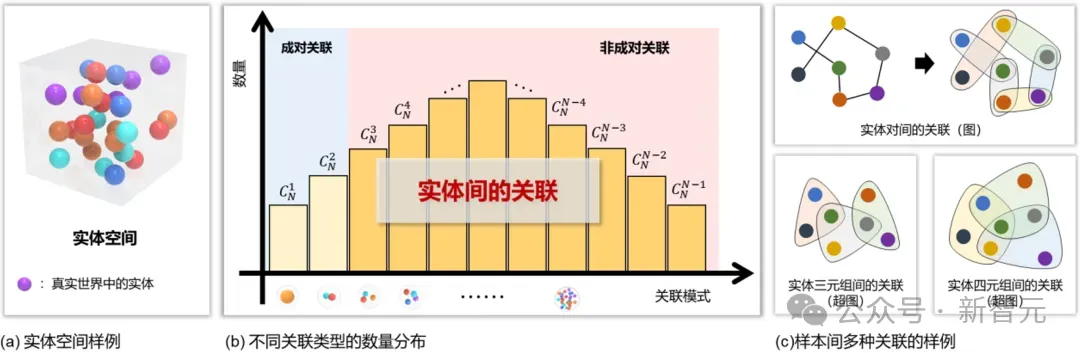

然而,现有的基于图的RAG方法受限于仅能表示实体之间的成对关联,无法表示那些更复杂的多实体间的群组高阶关联,导致数据结构化过程中这些高阶信息的丢失。

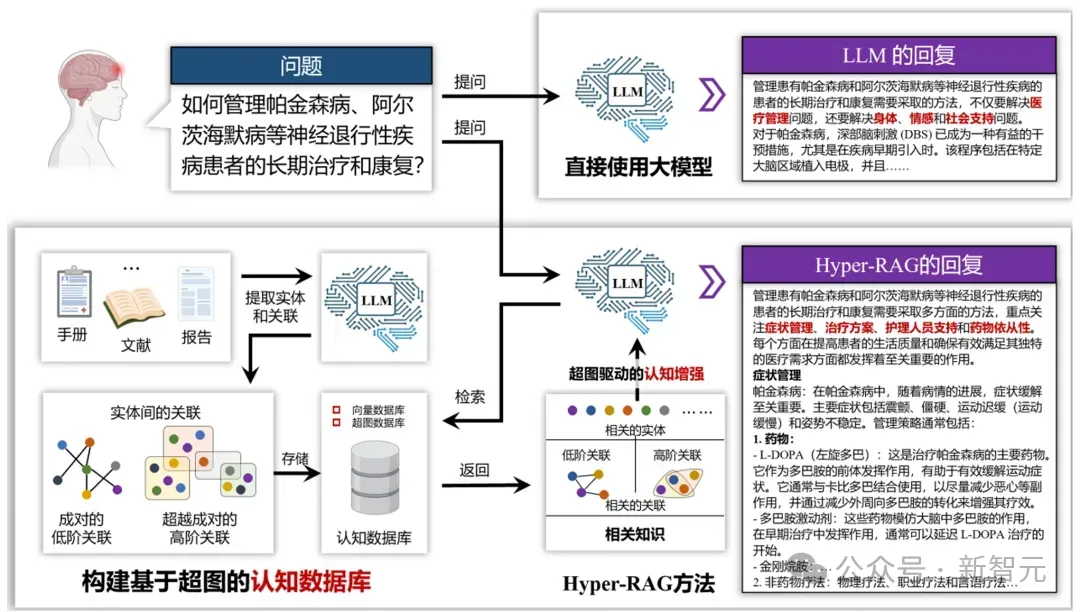

为了解决这一难点,清华大学、西安交通大学等提出Hyper-RAG:一种超图驱动的检索增强生成方法。

Hyper-RAG将超图表征融入RAG中,通过超图捕获原始数据中的成对低阶关联和群组高阶关联,从而最大限度减少领域知识结构化带来的信息损失,提高生成响应的准确性和可靠性,可以作为医疗诊断金融分析等高可靠需求应用的有利支撑。

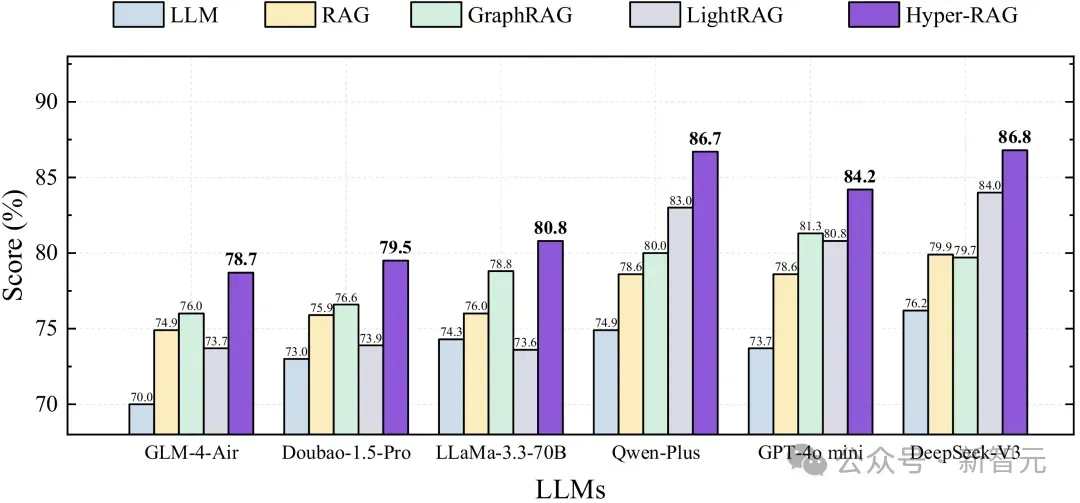

在神经科学任务上对六种LLMs进行的实验表明,Hyper-RAG相比于直接使用LLM,其准确率平均提升了12.3%,比GraphRAG和LightRAG分别高出6.3%和6.0%。

此外,Hyper-RAG在查询问题复杂性增加的情况下仍能保持稳定性能,而现有方法的性能则有所下降;其轻量级变体Hyper-RAG-Lite在检索速度上达到了Light RAG的两倍,并且性能提升了3.3%。

论文地址:https://arxiv.org/abs/2504.08758

Github仓库:https://github.com/iMoonLab/Hyper-RAG

Hyper-RAG集成系统

超图驱动的本地检索增强大模型

超图本地知识库可视化系统

RAG困境

现有基于知识结构化的RAG方法,如Graph RAG和Light RAG,利用图结构来表示特定领域文本中的关系信息。

然而,基于图的方法仅限于成对关系 ,限制了其捕捉复杂互连的能力,如下图所示,在叙事故事中,虽然图可以有效地模拟人物之间错综复杂的相关关系,但却不足以表示涉及多个人物同时互动的事件。

,限制了其捕捉复杂互连的能力,如下图所示,在叙事故事中,虽然图可以有效地模拟人物之间错综复杂的相关关系,但却不足以表示涉及多个人物同时互动的事件。

在叙事故事中,虽然图可以有效地模拟人物之间错综复杂的关联,但却不足以表示涉及多个人物同时互动的事件。在构建知识图谱的过程中,通常会丢失这些超出成对相关的关联,从而导致信息的损失。

相比之下,超图能够对多个数据点之间的高阶关联( 及以上)进行建模,提供了更全面的领域知识表示。

及以上)进行建模,提供了更全面的领域知识表示。

研究人员探讨了基于超图的RAG技术,以实现关键知识的全面覆盖。通过整合基于超图的结构,大型语言模型能够更好地减轻与关键信息相关的幻觉现象,从而增强其在专业领域输出的可靠性和准确性。

超图建模索引

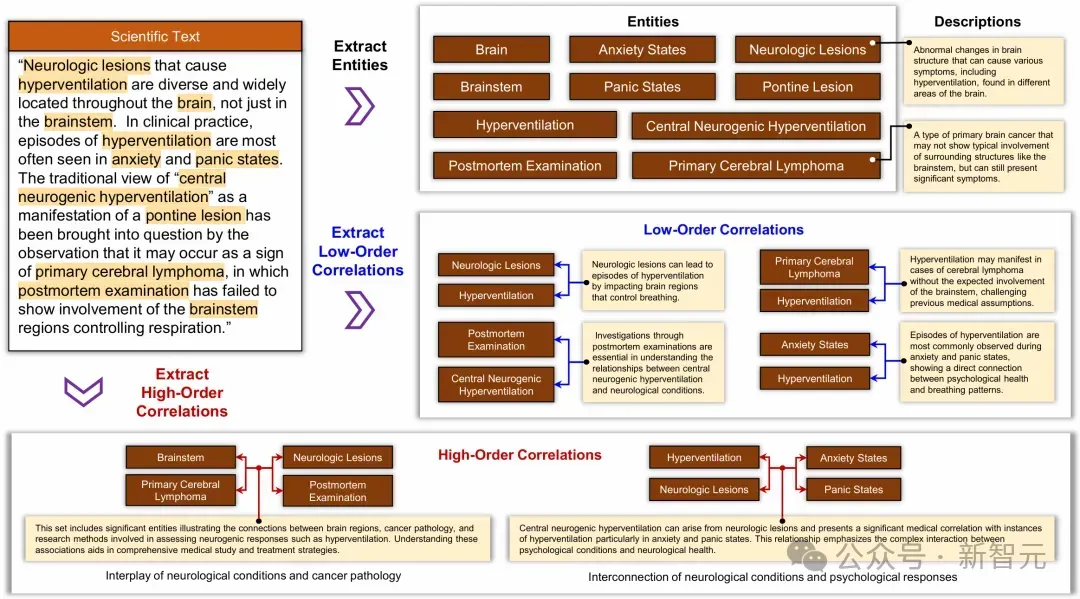

下图举例说明了如何从原始语料中提取实体、低阶关联和高阶关联。可以看出,加入高阶关联可确保更全面地检索相关信息。与此相反,如果使用传统图,则仅提取成对相关性,会导致潜在的信息丢失,从而导致大模型产生幻觉。

方法概述

为了减少LLM的幻觉,Hyper-RAG将超图建模纳入RAG框架,利用超图来捕捉错综复杂的多方面相关性。

具体来说,首先,从原始数据集中提取实体,作为超图中的节点。随后,这些实体之间的低阶和高阶关联会被识别和整合,从而构建一个基于超图的知识库。

在查询阶段,首先从输入查询中提取关键实体,然后利用超图结构从知识库中检索相关的先验语料信息。

知识索引

在Hyper-RAG中,语料库数据可以包含各种类型的文档,包括书籍、手册、报告和其他相关文本。首先对原始文档进行预处理,并将其划分为大小一致的chunk,从而形成语料库集合:

随后,使用文档结构函数Φ从语料库中提取结构信息,从而得到超图G。

其中,v表示不同元素实体的集合, 分别表示实体间的低阶和高阶关联。

分别表示实体间的低阶和高阶关联。

检索增强

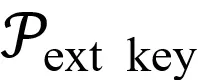

在查询环节给定一个查询q,首先提取两组不同的关键词集合:实体关键词

(基本组件)和关联关键词 (复杂的相互依赖关系),如下所示:

(复杂的相互依赖关系),如下所示:

其中, 是用于从输入问题中提取关键字的提示词。随后,基于这两类提取的关键词,从超图数据库中检索相关信息。

是用于从输入问题中提取关键字的提示词。随后,基于这两类提取的关键词,从超图数据库中检索相关信息。

值得注意的是,实体关键字检索的目标是顶点,而关联关键字检索的目标是超边。出现这种区别是因为实体关键字主要描述单个实体,使顶点成为合适的检索对象。

相反,相关性关键词描述的是抽象信息,通常涉及多个实体之间的关系,因此需要超边作为检索目标。

对于实体信息检索,通过扩散实体对应的超边作为补充信息,对于关联信息检索,通过扩散超边对应的实体作为补充信息:

通过超图知识库进行一步扩散,获得与这些实体相关的超边/超边相关的节点作为补充信息。

随后将顶点相关和超边相关的信息合并送给大模型以获得可靠知识补充,生成LLM对查询的回答。

实验结果

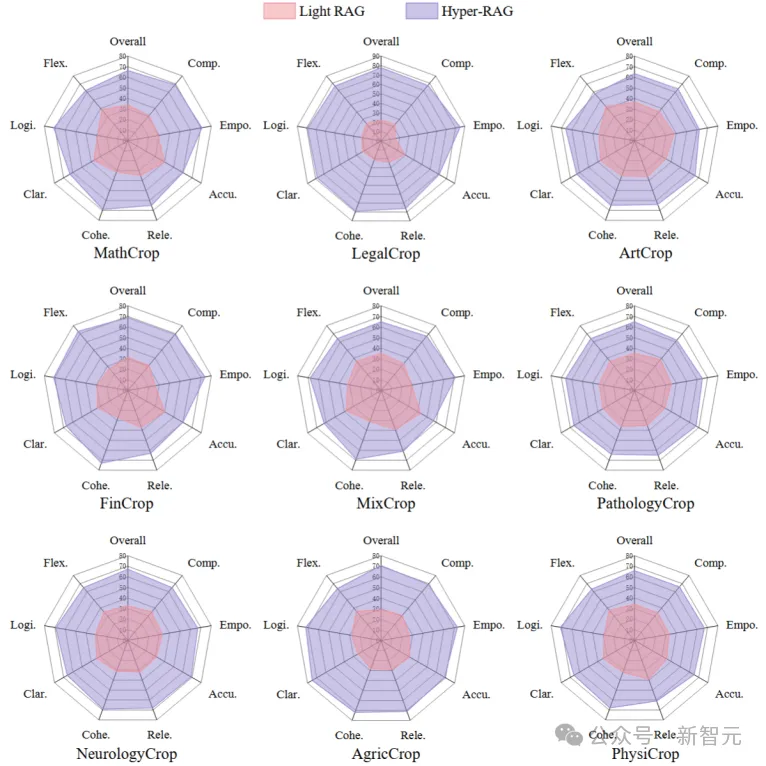

研究人员在9个不同领域数据集上(神经科学、病理学、数学、物理学、法律、艺术等),采用了6个不同大模型,2种不同评估策略,多维评价指标进行了实验验证。

基于打分的评估

在NeurologyCrop数据集上的实验结果表明,Hyper-RAG的性能优于直接应用LLM,平均提高了12.3%;此外,与GraphRAG和LightRAG相比,Hyper-RAG的性能分别提高了6.3%和6.0%。

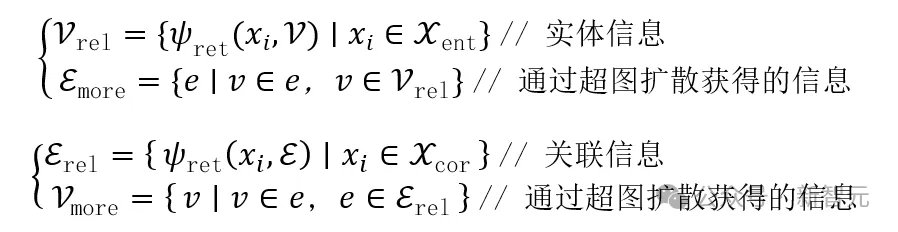

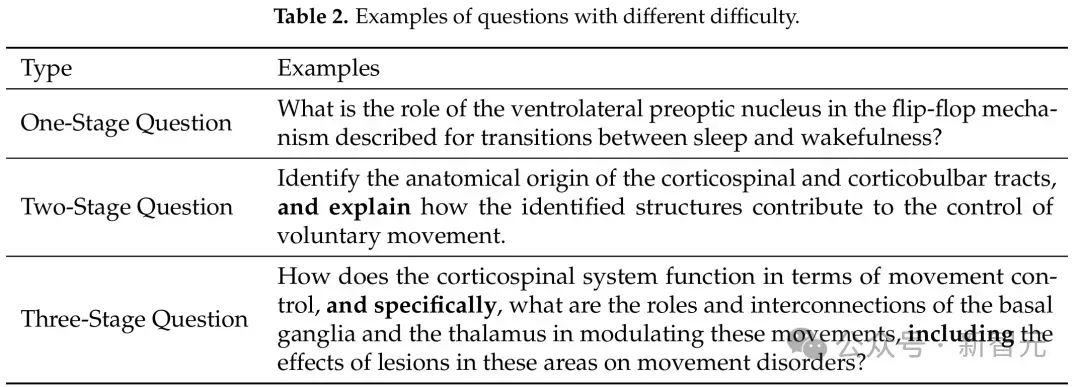

当通过引入嵌套,即一个问题后接另一个问题以增加复杂性,如下表所示。随着问题难度的增加,现有的LLM和基于RAG的方法的性能显著下降。相比之下,Hyper-RAG 保持了稳定的性能水平。

具体来说,随着问题难度的增加,Hyper-RAG与直接使用LLM相比,性能提高了12.7%到15%。这些结果证实了基于超图的全面信息表示的优越性。

对于简单的查询,直接来自大型语言模型的回答或简单的成对(即低阶)关联可能已足够。

然而,随着查询变得更加复杂,复杂的高阶关联的可用性对于约束和丰富模型的输出变得至关重要,这一实验趋势强调了开发基于超图的结构表示和检索方法,以应对日益复杂的问题所带来的挑战的重要性。

基于选择的评估

为了进一步验证Hyper-RAG,本文将实验扩展到跨越多个领域的九个不同语料库数据集。

在这些数据集中,Hyper-RAG的性能始终优于传统的基于图的方法Light RAG,在使用基于选择的评估方法对性能进行评估时,Hyper-RAG的平均性能提高了35.5%。

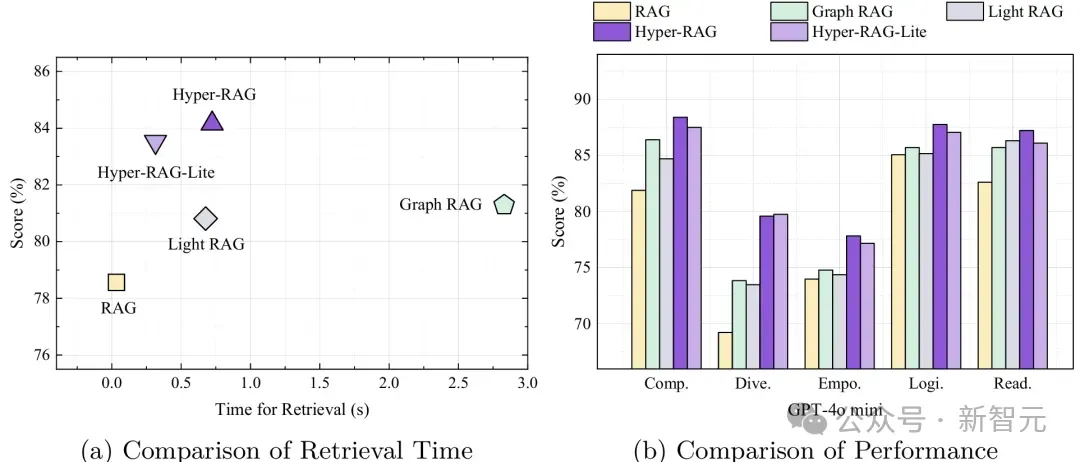

效率分析

这里进一步评估了从数据库本地检索获取相关知识和构建先验知识提示所需的时间。

作者开发了Hyper-RAG的轻量级变体,Hyper-RAG-lite,它保留了实体检索的基本增强功能。

可以看出,Hyper-RAG和Hyper-RAG-lite都位于图的左上角附近,这表明这些方法在速度和性能方面都优于其他方法。

总结

总结

Hyper-RAG通过利用超图对原始数据进行更加全面且结构化的知识表示,最大程度地减少信息丢失并降低大型语言模型的幻觉现象。

与现有的基于图的RAG方法相比,Hyper-RAG在多个不同领域的数据集上表现出更优异的性能,能够有效捕捉复杂的多实体群组高阶关系,从而提升生成内容的准确性和可靠性。

研究表明,Hyper-RAG在增强LLM的可靠性和减少不准确输出方面具有显著优势,能够更好地应对输出内容不可靠带来的挑战。

还没有评论,来说两句吧...