设想一下,你在家中准备起身,前往橱柜取东西。一个集成 SIF3D 技术的智能家居系统,已经预测出你的行动路线(路线通畅,避开桌椅障碍物)。当你接近橱柜时,系统已经理解了你的意图,柜门在你达到之前就已自动打开,无需手动操作。

视频中,左边为 3D 场景和预测结果(红色人体表示真实序列,蓝色人体表示预测结果)中间为运动序列最有可能和场景发生交互的点云,右边为每一个人体 pose 最有可能和场景发生交互的点云(红交互可能性大,蓝色交互可能性小)

SIF3D(Sense-Informed Forcasting of 3D human motion),即场景感知运动预测技术,由小红书创作发布团队提出,目前已被计算机视觉顶会 CVPR2024 收录。SIF3D 的先进之处在于其多模态感知能力。它结合人过去的动作序列、真实 3D 场景信息以及人的视线三个方面,预测未来的人体运动。

这项技术特别擅长于理解和预测在复杂环境中的动作,如避开障碍物,这对于自动驾驶、机器人导航、游戏开发和虚拟现实等领域至关重要。比如使得汽车能够更准确地提前预测马路上的行人、车辆未来可能的运动趋势,或是应用于医疗康复诊疗,提前对病人可能发生的不安全运动行为进行预警等。

SIF3D 的工作原理是:通过两种创新的注意力机制——三元意图感知注意力(TIA)和场景语义一致性感知注意力(SCA)——来识别场景中的显著点云,并辅助运动轨迹和姿态的预测。TIA 专注于预测人的意图和全局动作轨迹,而 SCA 则专注于局部场景细节,确保每一帧的姿态预测都与环境保持连贯性。

实验结果表明,SIF3D 在多个大规模场景感知运动预测的数据集上的卓越性能(SOTA),预测时长突破目前算法边界,达到 5 秒时长。它能够有效地识别场景中那些可能与人的运动相关联、相耦合的部分(显著性区域),并通过场景中显著性区域的特征辅助运动预测。这一开创性的方法,不仅推动了人体运动预测技术的发展,也为未来在更多场景下应用场景感知人体运动提供了新的方向和可能性。

一、背景

人体动作预测(Human Motion Forecasting),即根据观测到的人体运动序列预测其将来的动作,这是机器智能(MI)、自动驾驶汽车(AD)和人机协作(HRI)等领域的关键技术。在现实生活中,人类的动作是与周围环境紧密相连的,比如我们会因为障碍物而改变行走路径。然而在现有的运动预测研究中,场景信息却常常被忽略,大大制约了技术在真实 3D 场景下的应用。

在机器人技术中,场景信息通常被表达为 3D 点云。现有的场景感知运动预测的方法,通常会将整个 3D 点云进行编码,而后通过全局嵌入或索引、插值等手段将其作为条件引入至运动预测任务当中。尽管该方法可行,但我们注意到:并非点云中的所有信息都与运动预测任务同等相关,相反,往往只有小部分的场景点云会对我们当前序列的运动预测起到作用,我们称其为显著点云(salient point clouds)。

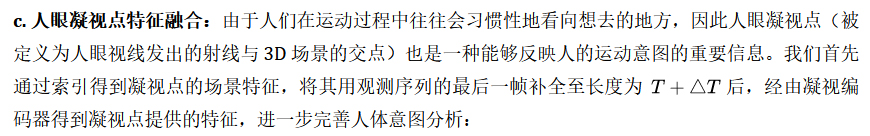

此外,人眼的凝视点(与场景的交汇点)也是一种能够体现人的运动意图的表现。我们期望通过联合分析 3D 场景和人眼凝视点,可以捕捉人类向特定位置的运动行为,从而更准确地预测其运动序列。

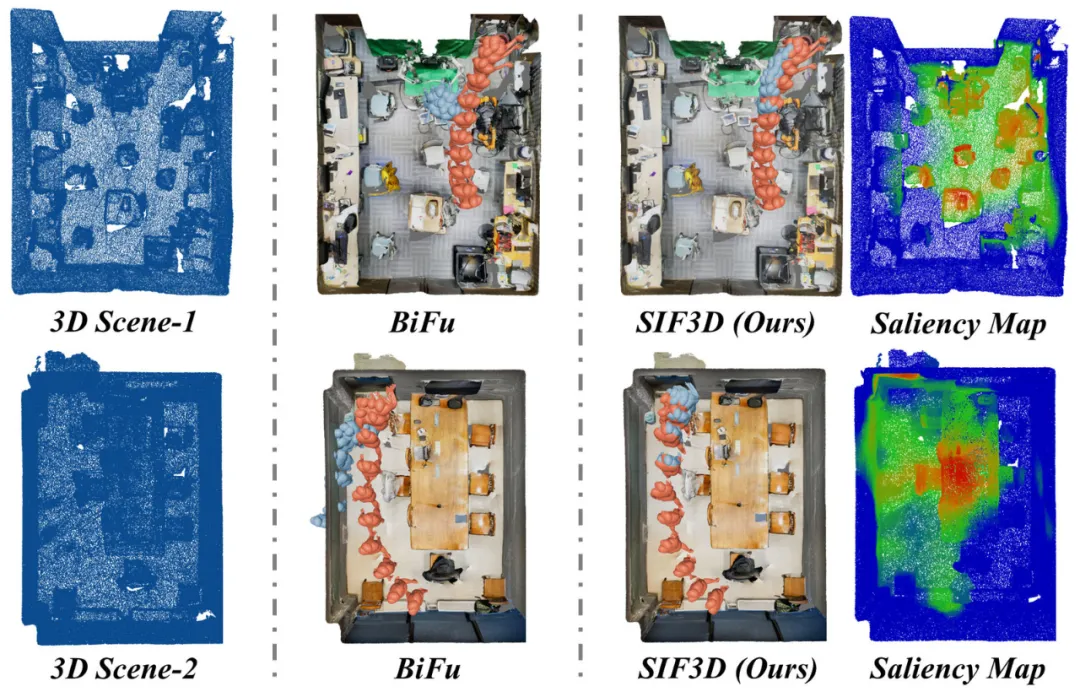

3D 场景(左),传统运动预测(中)与本文提出的场景感知预测(右)的对比

为了解决上述挑战,我们提出了一种全新的多模态场景感知的运动预测方法 SIF3D(Multimodal Sense-Informed Forecasting of 3D Human Motions)。SIF3D 主要包含以下两个核心组件:

三元意图感知注意力机制(ternary intention-aware attention,TIA):通过观测序列、场景点云、人眼凝视的三元多模态联合分析,预测人的意图并区分全局显著点云(global salient points),用于辅助人体运动轨迹预测

场景语义一致性感知注意力机制(semantic cohenrence-aware attention,SCA):逐帧分析运动序列与场景语义的连贯性与一致性,区别得到逐帧的局部显著点云(local salient points),用于辅助人体姿态预测

通过在新引入的大型数据集上的广泛实验,SIF3D 在真实场景下的 3D 人体运动预测方面取得了最优越的性能,证明了其捕获显著点云的准确性,以及通过显著点云辅助运动预测的有效性。此外,这些发现同样为将来基于真实场景的高保真运动预测、人机交互等领域的应用提供了新的视角和可能性。

二、方法

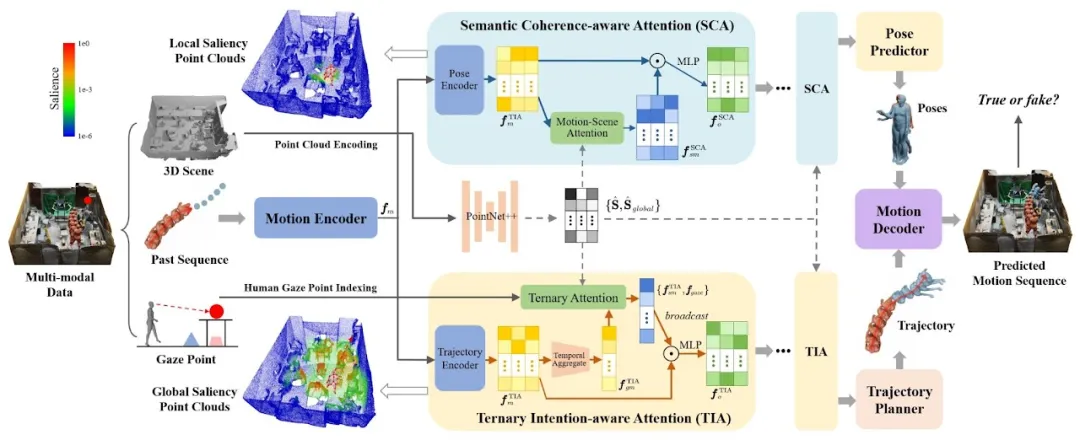

SIF3D 算法流程图

如图所示,SIF3D 主要涉及以下三个核心步骤:

Encoding:通过点云网络(PointNet)和 Transformer 分别提取 3D 场景的空间信息与运动序列的时间、空间信息,并将其编码为高维隐藏特征;

Crossmodal Attention:通过提出的三元意图感知注意力机制(TIA)与场景语义一致性感知注意力机制(SCA)提取 3D 场景中的全局与局部显著点云,并通过跨模态注意力机制分别辅助运动轨迹与姿态的预测;

Decoding:融合 TIA 与 SCA 预测的轨迹与姿态,并使用真伪判别器进一步监督预测序列的保真度。

2.1 多模态编码(Multimodal Encoding)

由于 SIF3D 使用到了三种模态的信息(运动序列、3D 场景点云、人眼凝视点),在对它们进行联合分析之前,我们首先需要将运动序列与 3D 场景点云编码并映射至同一空间,而人眼凝视点则作为索引,用于获取凝视点的 3D 场景特征。具体操作如下:

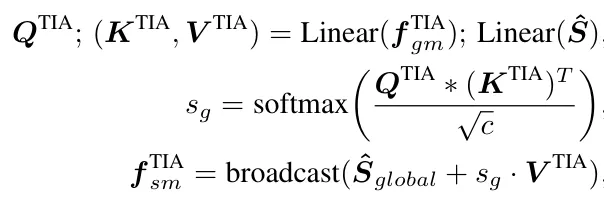

2.2 三元意图感知注意力机制(TIA)

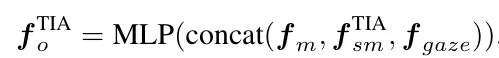

三元意图感知注意力机制(ternary intention-aware attention,TIA)通过分析观测序列与场景之间的关系,同时基于“人们大多数时候总是会走向看着的地方“这一先验来分析这三种模态间的关联,并通过以下步骤辅助路径规划:

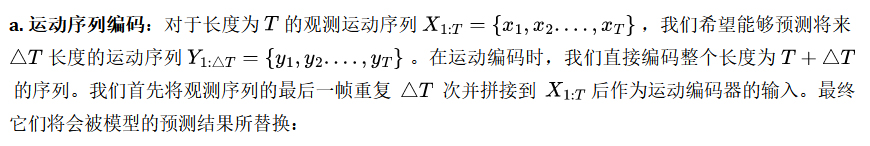

a. 运动特征编码与聚合:短期内,人的意图在运动序列中具有唯一性且不会随着运动的持续进行而发生变化,因此我们首先对运动特征进行进一步编码,并将整个序列的运动特征聚合为一个向量:

b. 全局显著性点云识别:将聚合得到的运动特征与场景特征进行跨模态注意力分析,寻找出场景中那些响应当前观测序列的点云,作为全局显著点云,我们仅会利用全局显著点云用于提取跨模态意图特征,并用于辅助轨迹预测:

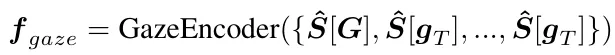

d. 全局特征特征融合:通过三元多模态感知,我们试图从多个维度来分析人的运动意图,最后我们通过标准的多层感知机(MLP)来融合这些全局特征,作为 TIA 的输出:

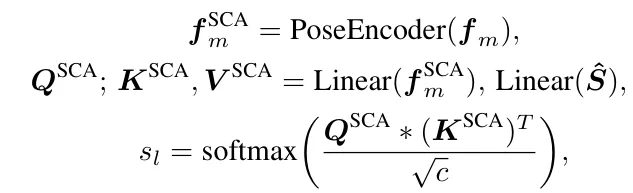

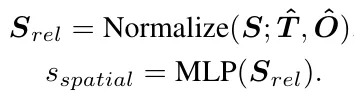

2.3 场景语义一致性感知注意力机制(SCA)

不同于 TIA 关注全局特征与人的运动意图,场景语义一致性感知注意力机制(SCA)则更加关注每一帧的局部显著性场景细节,用来更好地指导每一帧局部姿态的预测:

a. 局部点云显著度:我们首先对运动特征进一步编码,得到每一帧的姿态特征,并将它们分别与场景特征进行跨模态注意力分析,来找到场景中响应每一帧运动姿态的局部显著性点云。

b. 空间显著度偏置:由于 SCA 会更关注场景中的一些可能影响人体姿态的细粒度信息,且正对着人的朝向且距离更近的场景点往往更可能会影响人体姿态,我们基于每个场景点相对于每一帧中人体的距离与方向额外对于局部点云显著性引入了一项空间显著度偏置 Sspatial:

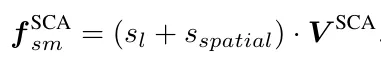

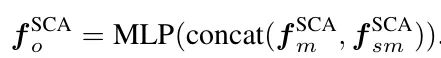

c. 局部特征特征融合:结合了局部点云显著度与空间显著度偏置,我们同样只利用局部显著性点云来辅助姿态预测:

而后利用多层感知机(MLP)来融合局部特征,作为 SCA 的输出:

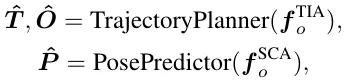

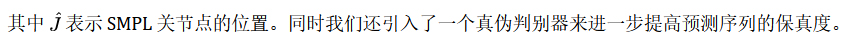

2.4 运动序列解码与生成

预测未来的运动序列需要同时考虑轨迹和姿势。TIA 通过识别全局显著点云分析了人的意图,而 SCA 则识别局部点云以维持每一帧人体与环境的连贯性与一致性,因此我们利用 TIA 的特征预测轨迹,而用 SCA 的特征预测人体姿态:

由于分别预测得到的轨迹与姿态可能存在不一致,因此我们利用一个基于图网络(GCN)的解码器来融合它们并得到最终结果:

三、实验

3.1 实验设置

本文基于 GIMO 与 GTA-1M 两个近期发布的包含 3D 场景点云的人体运动数据集,将 SIF3D 与包含经典方法、最新最优方法在内的 4 个方法进行了对比:基于图网络的 LTD、SPGSN,基于 Transformer 的 AuxFormer,以及考虑了场景信息的 BiFu。

本文从轨迹与姿态两个维度对 SIF3D 与对比方法进行了评估,轨迹评估计算了预测轨迹与真实轨迹之间的偏差,姿态评估了则计算了每个关节点的位置与真实位置的平均偏差。

对于所有的指标我们都从所有的预测帧与最终的预测帧两个方面来评估,包括:

Traj-path:衡量了整个预测序列中平均的轨迹偏差;

Traj-dest:衡量了最终预测帧的轨迹偏差;

MPJPE-path:衡量了整个预测序列中的平均姿态关节点偏差;

MPJPE-dest:衡量了最终预测帧的平均姿态关节点偏差。

3.2 实验结果

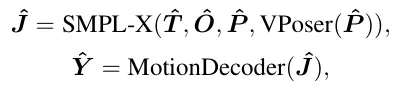

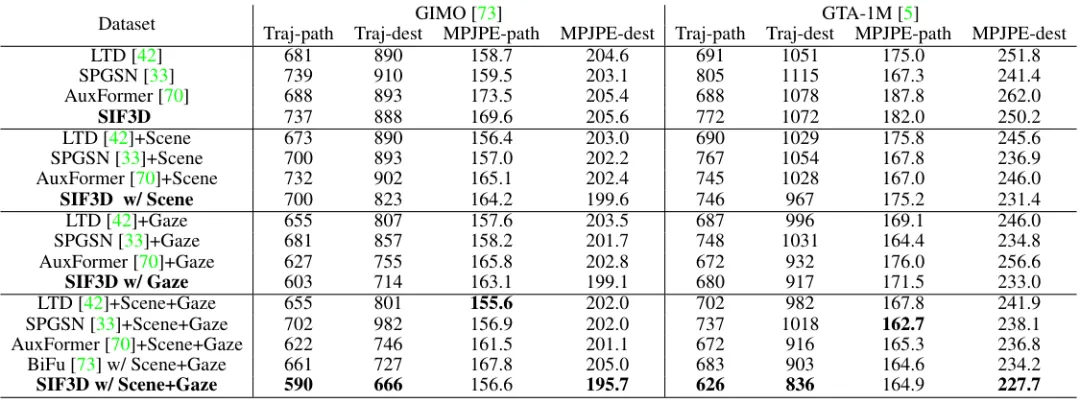

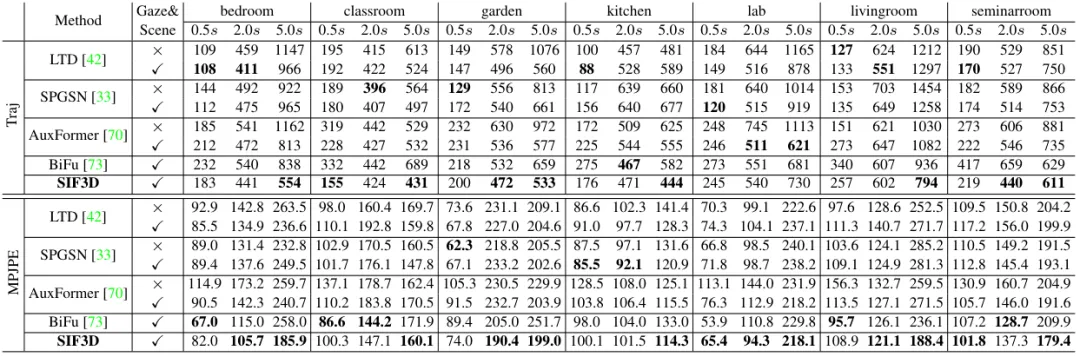

我们首先统计了引入不同多模态信息时(3D 场景点云 Scene,人眼凝视点 Gaze),各个方法的预测性能(表 1),而后详细展开统计了不同场景以及不同时间点下各个方法的预测性能(表 2)

表 1:考虑了不同模态时(3D 场景点云 Scene,人眼凝视点 Gaze)各个方法的预测结果

表 2:不同场景以及不同时间点下各个方法的详细预测性能

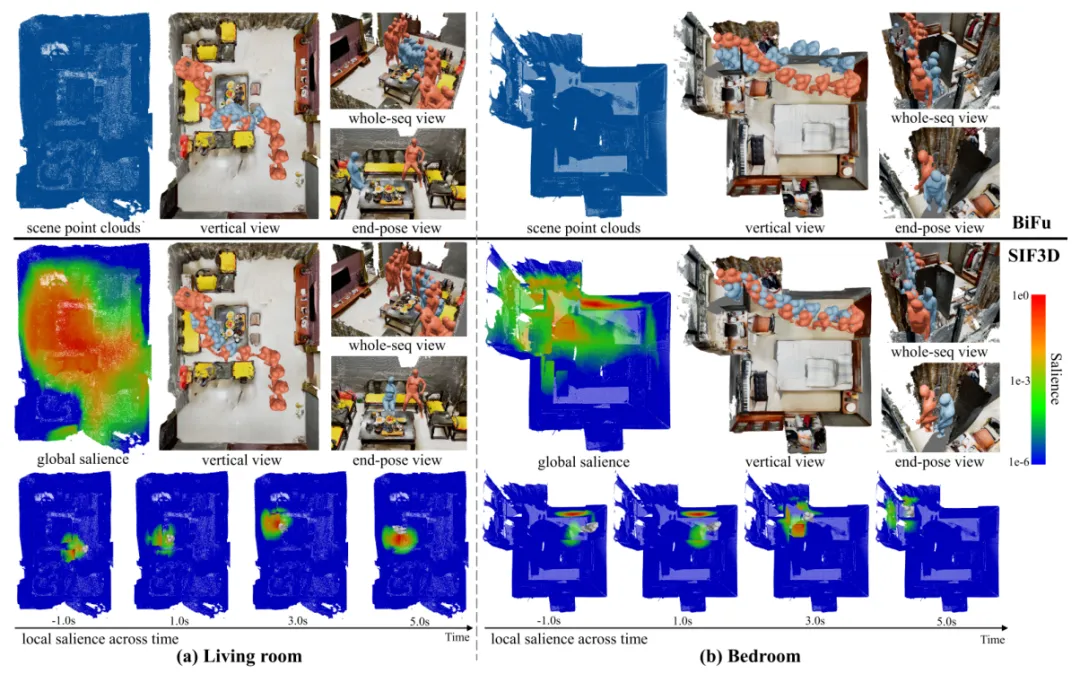

3.3 可视化对比结果

可视化结果提供了一种更为直观的方法将 SIF3D 与传统方法进行了对比。

通过识别场景中的全局与局部显著点云,我们可以更高效地利用场景信息辅助运动预测,得到更为精准与真实的预测序列。我们可以清楚地看到,SIF3D 不但能更好地识别场景元素,还能感知人的意图,其预测结果不但更接近真实序列,也具有更高的保真度。

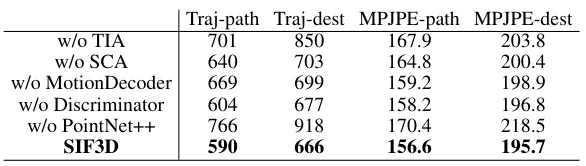

3.4 消融实验

消融实验(Ablation Study)旨在评价 SIF3D 中不同组件的重要度以及对最终预测性能的影响,即通过移除或修改某些部分来评估模型性能的变化。主要包括:

a. 移除主要组件:

包括 TIA,SCA,运动解码器,真伪判别器与场景编码器 PointNet++。它们是构成 SIF3D 最主要的五个部件,通过比较移除这些组件前后的预测误差,可以评估它们在提高预测准确性方面的重要性,如下表所示。可以看出本文提出的组件均不同程度地有主提高最终的预测效果,尤其是意图注意力模组和场景编码模块。

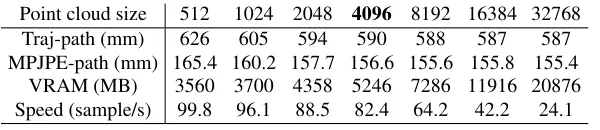

b. 调整场景点云大小:

原始的 LiDAR 传感器采样得到的场景点云可能包含 50 万以上的顶点数量,为了更高效地利用点云数据,我们对其进行了下采样。然而过度下采样可能影响点云对于场景的表征能力,因此我们需要权衡下采样的点云大小,如下表所示。本文实验采用了 4096 作为场景点云的大小。可以看到,在点云数量为4096时,算法在内存开销、推理速度、最终性能等方面取得了最佳平衡。

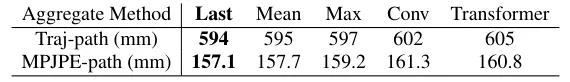

c. TIA 中的运动特征聚合方法:

在 TIA 中,我们将编码得到的运动特征聚合为一个向量用于计算与场景点云间的全局显著性,这里我们研究了不同聚合方式对于性能的影响,包括:

Last,采用最后一帧的运动特征;Mean,采用所有帧运动特征的均值;Max,采用帧间最大池化;Conv,利用三层卷积网络进行下采样;Transformer,引入单层 Transformer 解码器用于聚合。结果如下表所示。可以看出,使用运动特征的最后一个时间维度的特征作为计算场景相关性的key-query取得了最佳的性能,这也意味着:

(1)最后一帧的运动特征可能包含了之前所有时间的上下文信息;

(2)最后时刻的运动信息对于人类未来轨迹起到的作用最大。

四、结语

在本研究中,我们提出了一个开创性的多模态感知信息框架 SIF3D,用于在真实世界的 3D 场景中进行人体运动预测。通过结合外部客观的 3D 场景点云和主观的人眼凝视点,SIF3D 能够通过 TIA 与 SCA 注意力机制感知场景和理解人类意图的。在 GIMO 与 GTA-1M 两个数据集中,SIF3D 均取得了目前最佳的预测性能。与此同时,我们的发现强调了 3D 场景与人眼凝视点在场景感知的运动预测中的重要性。此外,我们认为,在现实世界的 3D 场景中深入研究高保真度的不同人体运动生成任务,有望成为未来探索的一条引人注目的途径。

项目地址:https://sites.google.com/view/cvpr2024sif3d

五、作者简介

楼震宇

本科毕业于浙江大学,目前为浙江大学博士生。发表多篇期刊和会议论文,主要研究方向为人体运动预测,3D 计算机视觉。崔琼杰

博士毕业于南京理工大学。在 CVPR、ICCV、ECCV、IJCAI、AAAI 等国际会议上发表多篇论文,担任多个国际顶级计算机视觉,人工智能会议的审稿人。目前主要研究方向为人体运动分析与合成。王浩帆

小红书创作发布组- AIGC 方向算法工程师,硕士毕业于卡内基梅隆大学,在 CVPR、ICCV、NeurIPS、3DV、AAAI、TPAMI 等国际会议和学术期刊上发表多篇论文。目前主要研究方向为图像、视频、3D 生成。

还没有评论,来说两句吧...