Llama3是Meta提供的一个开源大模型,包含8B和 70B两种参数规模,涵盖预训练和指令调优的变体。这个开源模型推出已经有一段时间,并且在许多标准测试中展示了其卓越的性能。特别是Llama3 8B,其具备小尺寸和高质量的输出使其成为边缘设备或者移动设备上实现LLM的完美选择。但是Llama3也还有许多缺陷,因此,在场景应用中,有时候还需要对其进行微调,以提升中文能力、场景应用的专业度等。

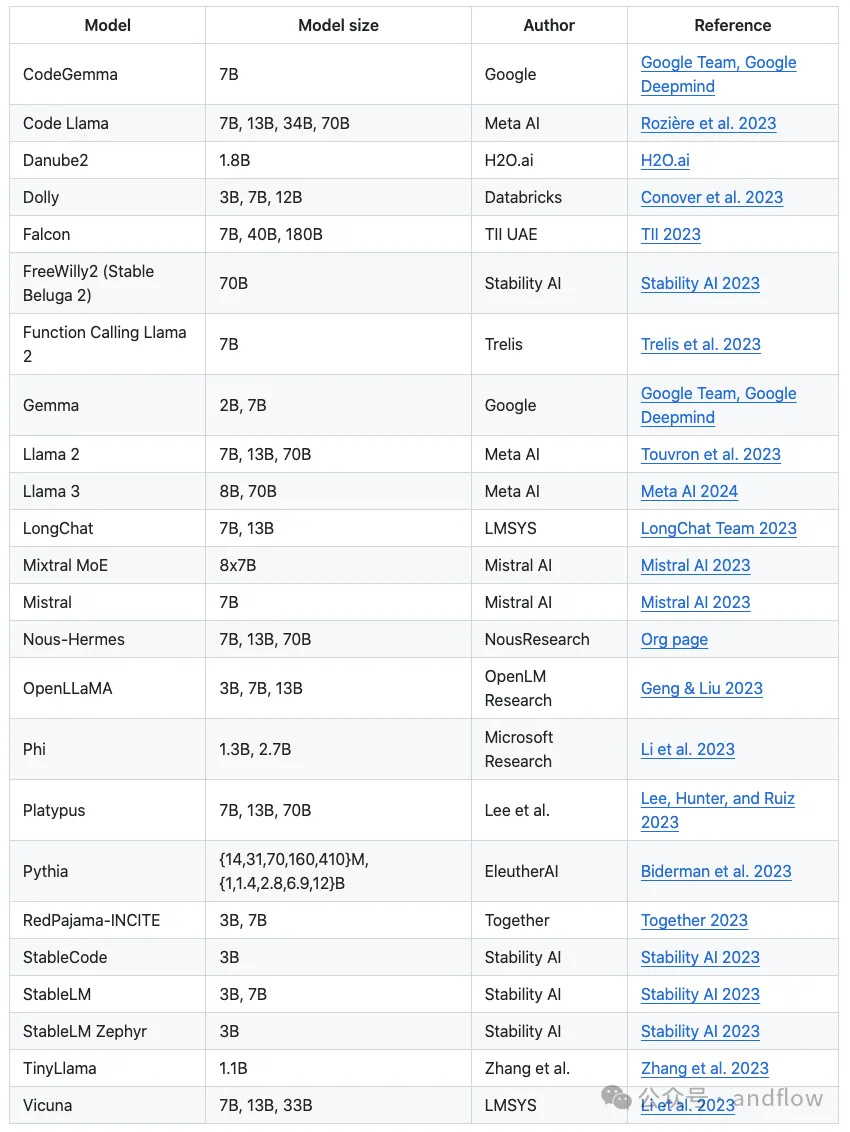

目前有许多团队在做微调工具,他们的贡献提高了我们的效率、减少失误。比较优秀的例如:

MLX-LM

PyReft

litgpt

LLaMA-Factory

本文主要介绍如何使用这几个工具进行微调,以及如何在Ollama中安装运行微调后的模型。

一、MLX-LM

MLX团队一直在不懈地努力改进MLX-LM库在模型微调工具方面的能力。使用MLX-LM微调llama3十分简单。

可以参考相关例子:https://github.com/ml-explore/mlx-examples/tree/main/llms/llama

大致步骤如下:

1.准备训练数据

glaiveai/glaive-function-calling-v2是一个专门用于训练大语言模型处理函数调用方面的数据集。我们可以下载这个数据集,并将数据转换为适合Llama3对话的格式,并保存到"/data"目录下。

数据下载地址:https://huggingface.co/datasets/glaiveai/glaive-function-calling-v2

数据格式转换的脚本如下:

2.安装mlx-lm包

这个库为微调LLM提供了一个友好的用户交互方式,省去了许多麻烦,并实现更好的效果。

3.创建LoRA配置

通过配置LoRA来微调Llama3 8B模型。更改一些关键参数以优化性能:

使用fp16代替qlora,以避免由于量化和解量化而导致的潜在性能下降。

将lora_layers设置为32,并使用全线性层,以获得与全微调相媲美的结果。

以下是lora_config.yaml文件的示例:

4.执行微调

在数据准备和LoRA配置就绪后,就可以开始微调Llama3 8B了,只需要运行以下命令。

5.模型融合发布

LoRa模型是无法单独完成推理的,需要和原生Llama结合才能运行。因为它freeze了原来的模型,单独加了一些层,后续的训练都在这些层上做,所以需要进行模型融合。

可以使用mlx_lm.fuse将训练过的适配器与原始的Llama3 8B模型以HF格式融合:

二、PyReft

项目源码:https://github.com/stanfordnlp/pyreft

ReFT方法的出发点是基于干预模型可解释性的概念,该概念强调改变表示而不是权重。这个概念基于线性表示假设,该假设指出概念被编码在神经网络的线性子空间中。

PyReFT是一个基于ReFT方法的库,支持通过可训练的干预来调整内部语言模型的表示。PyReFT具有更少的微调参数和更强的鲁棒性,可以提高微调效率、降低微调成本,同时也为研究自适应参数的可解释性打开了大门。

PyReft支持:

微调发布在HuggingFace上任何预训练大模型

可配置ReFT超参数

轻松将微调后的结果分享到HuggingFace

1.安装依赖库

使用Pip安装最新版本的transformers以支持llama3。此外,还需要安装bitsandbytes库。

2.安装或导入pyreft

安装Pyreft库。如果已经安装则将导入pyreft。

3.加载模型

在加载模型之前需要确保登陆到huggingface,以便于访问Llama3模型,可以使用下面的代码片段:

接下来就是设置用于训练的提示词模板。由于我们将使用基础模型,因此需要添加特殊的标记,以便模型能够学会停止并且不继续生成文本。下面的代码片段用于执行加载模型和标记器。

接着,设置pyreft配置,然后使用pyreft.get_reft_model()方法准备好模型。

4.准备数据集

下面以OpenHermes—2.5数据集为例。由于Reft Trainer的数据需要采用特定格式,因此我们使用:

来准备数据。

5.执行训练

为pyreft.ReftTrainerForCausalLM()设置训练参数。可以根据自己的使用情况和计算资源进行更改。下面的代码参数设置只训练1个epoch。

训练完成后,将干预块保存到reft_to_share目录中。

6.发布与推理

模型微调训练完成后要进行推理。需要加载基本模型,并通过合并干预块来准备reft模型。然后将reft模型转移到cuda。

接着进行推理测试:

三、litgpt

源代码:https://github.com/Lightning-AI/litgpt

LitGPT是一个可以用于微调预训练模型的命令行工具,支持20多个LLM的评估、部署。它为世界上最强大的开源大型语言模型(LLM)提供了高度优化的训练配方。

1.安装

2.评估测试

选择一个模型并执行:下载、对话、微调、预训练以及部署等。

例如:使用微软的phi-2进行对话评估。

3.微调模型

下面是在phi-2基础上进行微调的命令。

除此外,还可以基于自己的数据进行训练。详细参考GitHub。

4.部署

通过下面的部署命令,启动模型服务。

通过Http API访问服务。

四、LLaMA-Factory

源代码:https://github.com/hiyouga/LLaMA-Factory/

LLaMA-Factory 是一个开源项目,它提供了一套全面的工具和脚本,用于微调、部署和基准测试LLaMA模型。

LLaMA-Factory 提供以下功能,使得我们可以轻松地使用LLaMA模型:

数据预处理和标记化的脚本

用于微调 LLaMA 模型的训练流程

使用经过训练的模型生成文本的推理脚本

评估模型性能的基准测试工具

用于交互式测试的 Gradio Web UI

使用LLaMA-Factory 进行微调的步骤如下:

1.数据准备

LLaMA-Factory要求训练数据的格式如下:

每个 JSON 对象代表一个训练示例,其中包含以下字段:

instruction:任务指令或提示

input:任务的附加上下文(可以为空)

output:目标完成或响应

2.下载安装依赖包

3.执行微调

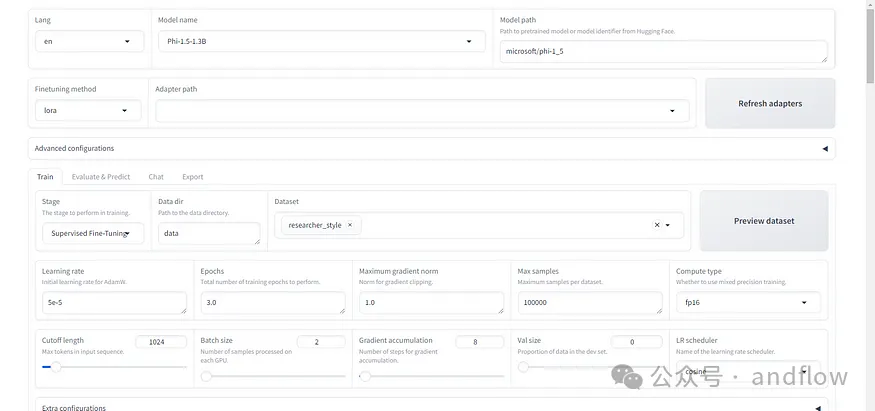

支持使用Python进行微调也支持图形化界面的方式。

下面是执行python脚本进行微调:

该脚本将加载预训练的LLaMA模型,准备训练数据集,并使用指定的超参数运行微调脚步。微调后的模型检查点将保存在 中output_dir。

主要参数设置如下:

model_name:要微调的基础 LLaMA 模型,例如llama-7b

data_path:标记数据集的路径

output_dir:保存微调模型的目录

num_train_epochs:训练周期数

batch_size:训练的批次大小

learning_rate:优化器的学习率

fp16:使用 FP16 混合精度来减少内存使用量

接着使用微调后的结果进行推理测试:

当然,微调过程也可以在可视化界面上进行。首先需要启动GUI界面。

4.基准测试

LLaMA-Factory 包含了基于各种评估数据集进行基准测试的脚本:

例如:

这个Python命令将加载经过微调的模型并评估其在指定方面的表现。

benchmark_datasets参数指明使用哪些数据集进行评估。评估报告包括:准确度、困惑度和 F1分数等指标。

还可以使用DatasetBuilder实现一个类并将其注册到基准脚本来添加您自己的评估数据集。

如何在Ollama中安装微调后的Llama3模型?

Ollama 是一个开源的大模型管理工具,它提供了丰富的功能,包括模型的训练、部署、监控等。通过Ollama,可以轻松地管理本地的大模型,提高模型的训练速度和部署效率。Ollama支持多种机器学习框架,如TensorFlow、PyTorch等,因此,我们可以根据需要选择合适的框架进行模型训练。

在使用LLaMA-Factory进行微调之后,会生成LoRA文件,如何在Ollama中运行llama3和我们训练出来的LoRA呢?

步骤如下:

1.运行Ollama

直接安装或者通过Docker安装运行Ollama

2.GGML格式转换

按照 Ollama modelfile ADAPTER 的说明,Ollama 支持 ggml 格式的 LoRA,所以我们需要把微调生成的 LoRA 转换成ggml格式。为此,我们需要使用到 Llama.cpp 的格式转换脚本:“conver-lora-to-ggml.py”。

例如:

执行完命令后,将在 /output/llama3_cn_01 下生成 ggml-adapter-model.bin 文件。这个文件就是 Ollama 所需要的ggml格式LoRA文件。

3.在Ollama中创建自定义Llama3模型

使用 ollama 的 modelfile 来创建自定义llama3模型。需要创建一个modefile文件。

我们创建一个llama3.modelfile,其内容如下:

接着使用Ollama命令以及modelfile来创建自定义模型:

查看模型列表:

运行模型:

还没有评论,来说两句吧...