这个研究探讨了大型语言模型(LLMs)在执行复杂推理任务时面临的计算资源消耗与响应延迟问题。研究特别聚焦于思维链(Chain-of-Thought, CoT)提示范式的效率局限性。CoT虽然有效,但在推理过程中需要生成冗长、详尽的逐步推理,导致计算资源利用率低下且延迟显著增加。这与人类问题解决机制形成鲜明对比——人类倾向于通过简洁的草图或速记笔记捕捉核心见解,避免冗余阐述。本研究旨在通过引入更高效的推理模式,缩小AI与人类认知处理方式间的差距。

方法论

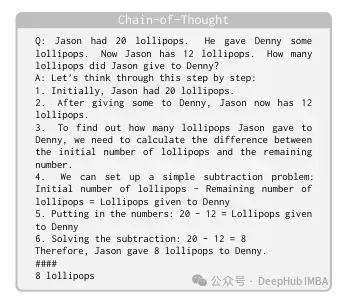

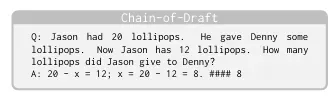

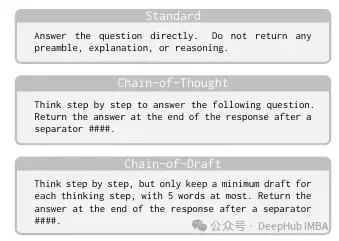

Chain of Draft (CoD) 是一种为大型语言模型(LLM)设计的创新推理策略,旨在通过生成简洁、高信息密度的中间输出来模拟人类认知过程。CoD方法论的核心特征包含多个维度:该方法鼓励LLM将每个推理步骤限制在五个单词以内,显著提高了表达的简洁性和处理效率;同时优先保留推进问题解决的关键信息,类似于人类在处理复杂任务时的要点记录行为。

CoD将复杂的推理过程浓缩为最小化的抽象表示,常将复杂问题提炼为简洁方程或核心概念。通过抽象化非关键上下文细节,CoD显著减少了token消耗,同时保持解决方案的透明度与准确性。

尽管CoD追求简洁,但仍然保持了逐步推理的范式,确保在复杂推理任务中能够实现逻辑连贯的进展。研究团队通过手动构建Chain of Draft示例用于小样本学习,向LLM展示了所需的简洁推理风格。值得注意的是,"每步五个单词"的限制作为一般性指导原则而非严格规范,保留了实际应用中的灵活性。

实验结果与分析

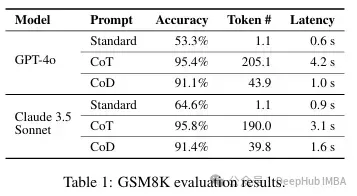

Chain of Draft (CoD)在提升计算效率的同时,在维持或超越思维链(CoT)提示准确性方面展现出显著成效。实验数据表明,与CoT相比,CoD使用的token数量减少至原来的7.6%,在保留基本推理逻辑的同时大幅降低了表达冗余度。在多种推理任务评估中,CoD实现了与CoT相当甚至更优的准确率。

token使用量的大幅减少直接转化为计算成本降低和响应延迟缩短,使LLM在实际应用场景中的适用性显著提升。CoD方法已在算术计算、常识推理和符号逻辑等多样化推理任务中验证了其有效性。这些实验结果表明,CoD提供了一种更为高效的LLM推理方法学,有潜力从根本上改变LLM在计算效率至关重要的生产环境中的应用模式。

总结

Chain of Draft (CoD)作为一种新型方法论,针对性解决了大型语言模型(LLM)一个关键但常被忽视的维度:推理能力与响应延迟之间的权衡问题。该方法通过显著降低LLM输出中的冗余表达,有效减少了延迟并降低了计算成本,同时保持甚至提升了相较于思维链(CoT)等传统方法的推理准确性。通过引导LLM生成简洁而关键的推理步骤,CoD显著降低了复杂推理任务所需的响应时间。这一创新对需要低延迟与高质量响应并存的实时应用场景尤为重要。CoD实现了与标准CoT提示策略相当或更高的准确率,成为在速度与精确度同等重要的实际应用场景中,提升LLM效率与实用性的有力解决方案。

还没有评论,来说两句吧...