实用软件

实用软件

置顶穿越数字边界:网络自由的探索

点击直达在当今数字化的世界里,网络自由是无价的,但有时也受到了地理和政治界限的限制。有一种方法,一种隐藏的方式,让我们能够穿越这些数字边界,实现网络自由。这个方法有点像背后的秘密通道,允许您访问被封锁或限制的网站,享...

实用软件

实用软件

点击直达在当今数字化的世界里,网络自由是无价的,但有时也受到了地理和政治界限的限制。有一种方法,一种隐藏的方式,让我们能够穿越这些数字边界,实现网络自由。这个方法有点像背后的秘密通道,允许您访问被封锁或限制的网站,享...

资源分享

资源分享

目前俄罗斯ozon在国内正处于超级红利期,平台自然流量很大,基本能做到上架即出单的地步,ozon官方计划在2024年要招商满10万卖家入入驻,乾坤未定,你我皆是黑马!平台现在跟13年的淘宝一样正在蓄力爆发,跨境电商时...

资源分享

资源分享

想进军俄罗斯电商市场,却担心门槛高、操作难?Ozon无货源模式让你0囤货、0风险、轻松赚钱!只需每天2小时,就能在俄罗斯开店!第一步:了解Ozon平台——轻松上手,0门槛副业Ozon平台支持无货源玩法,只需出一单发一...

AI动态

AI动态

译者 | 朱先忠审校 | 重楼本文将通过具体的实战代码示例来探索谷歌开源Gemini Flash模型的学习曲线和采样效率。在大多数常见的机器学习和自然语言处理中,实现最佳性能通常需要在用于训练的数据量和由此产生的模型...

AI动态

AI动态

随着 AI 模型的参数量越来越大,对算力的需求也水涨船高。比如最近,Llama-3.1 登上了最强开源大模型的宝座,但超大杯 405B 版本的内存就高达 900 多 GB,这对算力构成了更加苛刻的挑战。如何降低算力的...

AI动态

AI动态

随着大模型在人工智能领域的兴起,如何将其应用于垂直领域成为关键问题。本文描述了模型微调技术,通过调整预训练模型的参数,使其适应特定任务,从而提升模型在特定领域的表现。文中以 Yelp 数据集为例,详细介绍了如何使用...

AI动态

AI动态

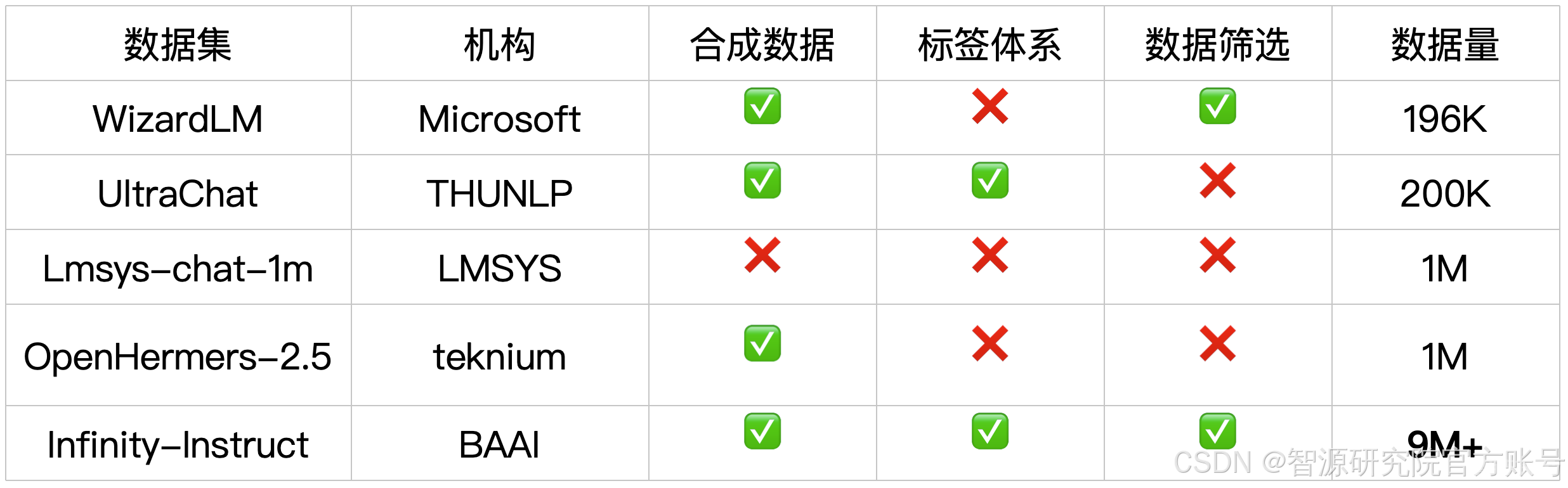

指令微调是引导语言模型落地、构建高性能对话模型的关键一步。针对目前开源的指令数据集质量低、覆盖领域少、数据信息不透明等问题,智源研究院推出了千万级指令微调数据集Infinity Instruct。该数据集今年6月发布...