就在昨天,Kimi宣布要把自家底层的大模型推理架构Mooncake开源出来!

有媒体称该架构正是承载了月之暗面Kimi线上80%以上流量的正在用的底层架构。

小编立马求证了一番,的确Github上有提到:Mooncake 正在服务Kimi平台。而且上线还不到一天就已经斩获了1600+ stars。

图片

图片

开源地址:https://github.com/kvcache-ai/Mooncake

1.开源最终目标:高性能语义存储的标准接口

“在大模型时代,更多的数据、更大的模型、更长的上下文窗口带来更高的智能,但也对大模型推理系统的效率提出更高挑战。如何应对高推理负载、降低推理成本、降低响应延迟成为业界共同面临的难题。”

大家都知道,月之暗面在长文本、深度推理、高并发等方面一直有着不错的研究和发布,这一次Kimi选择在感恩节将这个牛逼的技术开源出来,确实让大家感到意外和兴奋。

据月之暗面官方公众号介绍,此次是月之暗面联合清华大学等机构开源共建大模型推理架构Mooncake。

官方文档还透露了,本次开源将采用分阶段的方式:

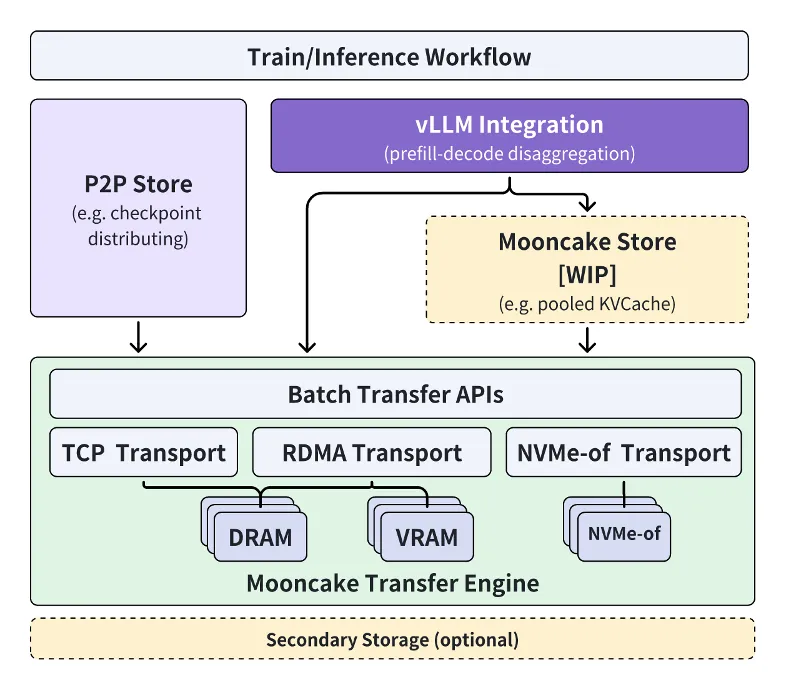

逐步开源高性能KVCache多级缓存Mooncake Store的实现,同时针对各类推理引擎和底层存储/传输资源进行兼容。

其中传输引擎Transfer Engine现在已经在GitHub全球开源。

其最终开源目标是,为大模型时代打造一种新型高性能内存语义存储的标准接口,并提供参考实现方案。

月之暗面Kimi工程副总裁许欣然表示:

通过与清华大学MADSys实验室紧密合作,我们共同打造了分离式大模型推理架构Mooncake,实现推理资源的极致优化。

Mooncake不仅提升了Kimi的用户体验,降低了成本,还为处理长文本和高并发需求提供了有效的解决方案。

我们相信,通过与产学研机构开源合作,可以推动整个行业向更高效的推理平台方向发展。

图片

图片

实际上,这个项目早在今年6月就已启动,当时已受到业内广泛关注——

图片

图片

2.大模型推理架构Mooncake核心思路

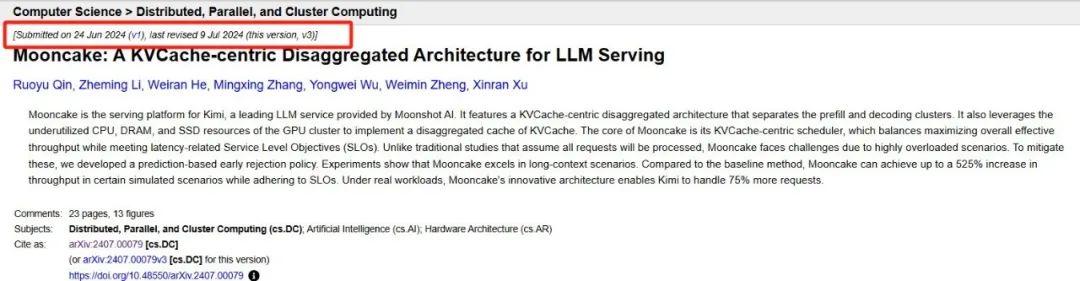

今年6月24日,月之暗面和清华大学MADSys实验室联合发布了Kimi底层的Mooncake推理系统设计方案。

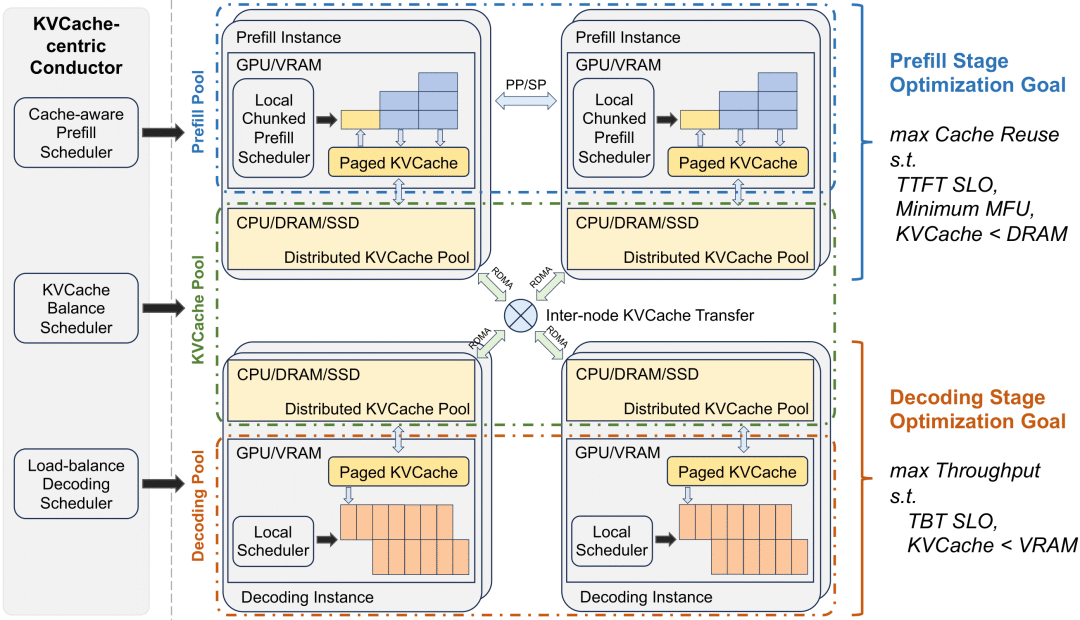

在这篇名为《Mooncake: A KVCache-centric Disaggregated Architecture for LLM Serving》的论文中,作者详细介绍了Mooncake这种系统架构。

该系统基于以KVCache为中心的PD分离和以存换算架构,大幅度提升了推理吞吐。

图片

图片

论文地址:https://arxiv.org/pdf/2407.00079

具体而言,Mooncake采用以KVCache为中心的解耦架构,将预填充集群与解码集群分离,并充分利用GPU集群中未充分利用的CPU、DRAM和SSD资源,实现KVCache的解耦缓存。

其核心思路在于以KVCache为中心的调度程序:

在最大化整体有效吞吐量和满足与延迟相关的服务级别目标 (SLO) 要求之间取得平衡

当面对流量高峰期时,Mooncake通过早期拒绝策略和预测未来负载的方法,来处理超载问题。

早期拒绝策略

简单说,其核心思想是在请求实际开始处理之前,根据当前系统的负载情况预测是否有足够的资源来处理新的请求。

如果预测结果表明系统资源不足以保证请求的及时处理,系统就会在请求到达之前予以拒绝,从而避免了无效的资源占用和不必要的延迟。

预测未来负载

在Mooncake中,系统需要能够预测在未来一段时间内的负载情况,以便做出更准确的接受或拒绝请求的决策。

3.如何实现?

通常来说,这种预测会基于当前的请求模式、系统的资源使用情况以及历史数据等信息。

再通过对信息的进一步分析建模,Mooncake就能够估计接下来的请求处理需求,并据此调整其调度策略。

论文实验结果显示,与基线方法相比,Mooncake在某些模拟场景中可以实现高达525%的吞吐量提升,同时遵守SLO(与延迟相关的服务级别目标)。

在实际工作负载下,Mooncake使Kimi能够处理75%以上的请求。

图片

图片

而且据许欣然在其他场合透露:目前这套系统承载了Kimi线上80%以上的流量。

图片

图片

4.开源阵容相当豪华!!!

而现在,为了进一步加速该技术框架的应用与推广,Kimi联合清华大学等机构共同发布开源项目Mooncake。

参与开源的首批阵容包括:

AISoft、阿里云、华为存储、面壁智能、趋境科技等。

可以说,云计算、存储、AI模型玩家等产学研力量都聚齐了。

据悉,Mooncake开源项目从论文延伸,以超大规模KVCache缓存池为中心,通过以存换算的创新理念大幅度减少算力开销,显著提升了推理吞吐量。

目前Mooncake技术框架已正式开源上线,官方还表示:

欢迎更多企业和研究机构加入Mooncake项目共建,共同探索更加高效和先进的模型推理系统架构创新,让基于大模型技术的AI助手等产品,持续惠及更广泛人群。

开源实在是一个大杀器,推理架构层面的开源,意味着Kimi正在重新定义自己在模型侧的运作模式甚至商业计划。希望看到国内LLM推理方面的开源能够进一步助力大模型应用的真正爆发!

参考链接:

https://mp.weixin.qq.com/s/NsKDtC7qp2JxA_EunwSqvg

https://mp.weixin.qq.com/s/-0YxV77HnEEtrvxJSSujmQ

还没有评论,来说两句吧...