无论是希望将AI大模型集成到业务流程中,还是寻求企业客户服务自动化,亦或者是希望创建一个强大的个人学习工具。可能都需要考虑数据安全、灵活度以及更具有可控性的使用和开发基础。值得考虑的一个方案是:将大模型(LLM)私有化并且创建一个好用的LLM WebUI系统。

下面,我们推荐七个出色的开源LLM WebUI 系统。

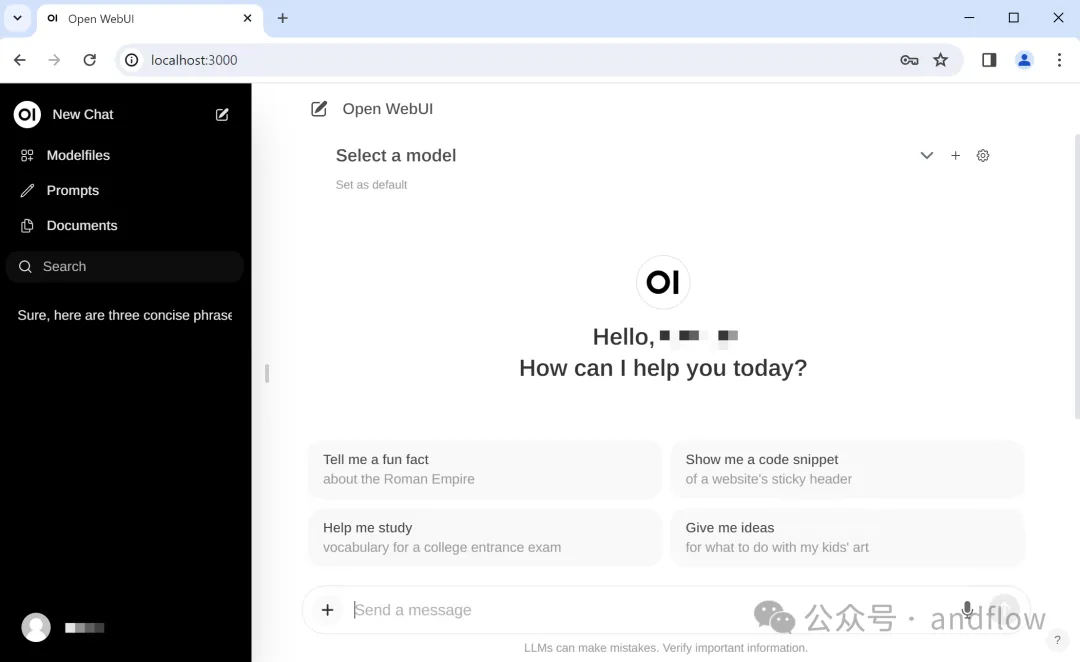

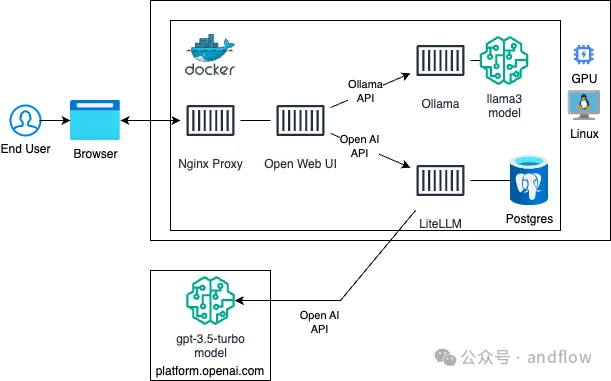

1.Open WebUI(Ollama WebUI)

https://github.com/open-webui/open-webui

Star:45.7K

开发语言:Python、TypeScript\Svelte

Open WebUI是一个可扩展、功能丰富且用户友好的WebUI,旨在完全离线操作。它支持包括Ollama和OpenAI在内的各种LLM运行容器或者API。

产品特点:

直观的界面:受ChatGPT启发的用户友好型聊天

响应式设计:在桌面和移动的上实现流畅的性能

轻松安装:使用Docker/Kubernetes轻松安装

主题定制:个性化与多个主题

高亮:增强代码的可读性

Markdown LaTeX支持:全面的格式选项

本地RAG集成:使用#命令访问聊天文档

RAG嵌入模型支持:选择嵌入模型(Ollama/OpenAI)

Web浏览:使用#命令集成网站

提示预设:使用/命令快速访问

RLHF注释:人工反馈的速率消息

会话标记:对聊天进行分类,以便于参考

模型管理:下载、删除和更新模型

GGUF文件上传:从GGUF文件创建Ollama模型

多模型支持:切换模型以获得不同的响应

多模式支持:包括图像交互

模型文件生成器:自定义角色和代理

多模型对话:同时利用多个模型

协作聊天:使用@ command分组模型对话

本地聊天共享:在用户之间共享聊天链接

Regeneration聊天历史:访问所有过去的互动

存档导入/导出聊天:组织和传输聊天数据

语音输入:自动发送语音输入

可配置的TTS端点:自定义文本到语音

高级参数控制:调节温度,系统提示

映像生成集成:本地API和DALL-E选项

OpenAI API支持多种API:灵活集成

API密钥生成:简化OpenAI库使用

外部Ollama服务器连接:连接远程实例

Ollama负载平衡:分发请求以提高可靠性

多用户管理:用于用户监督的管理面板

Webhook集成:新注册的实时通知

模型白名单:用户的受控访问

可信电子邮件身份验证:增强的安全层

RBAC:基于角色的受限权限访问

后端反向代理:安全的后端通信

多语言支持:i18n国际化

持续更新:定期的新功能和改进

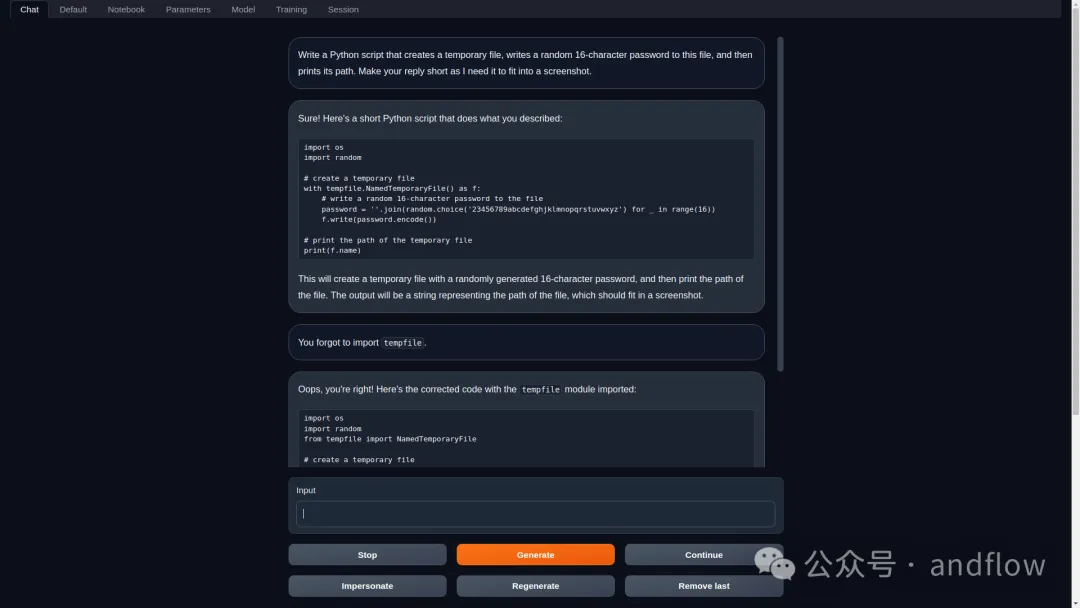

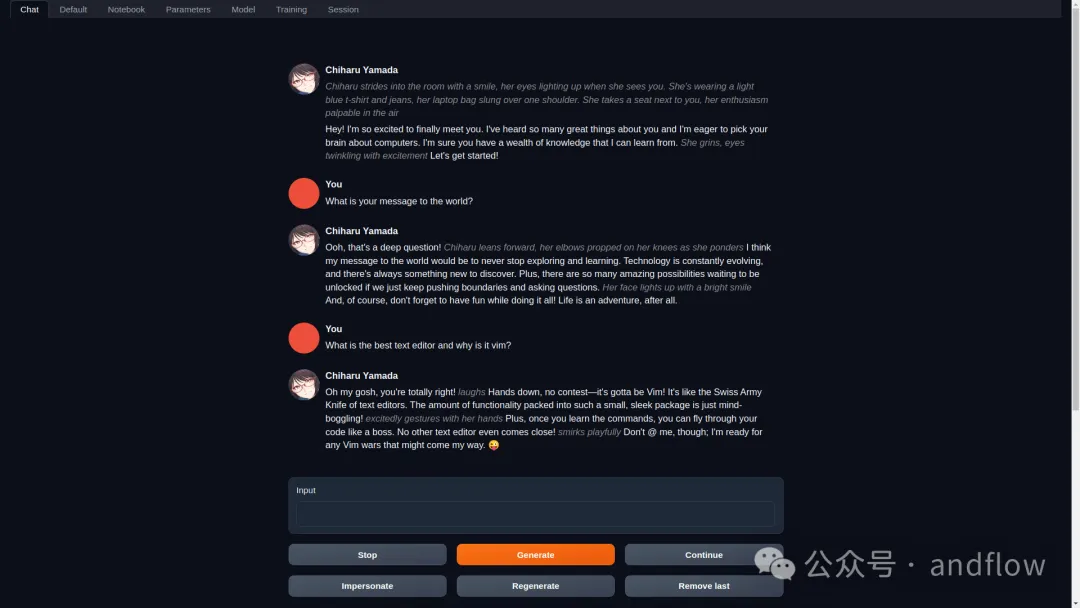

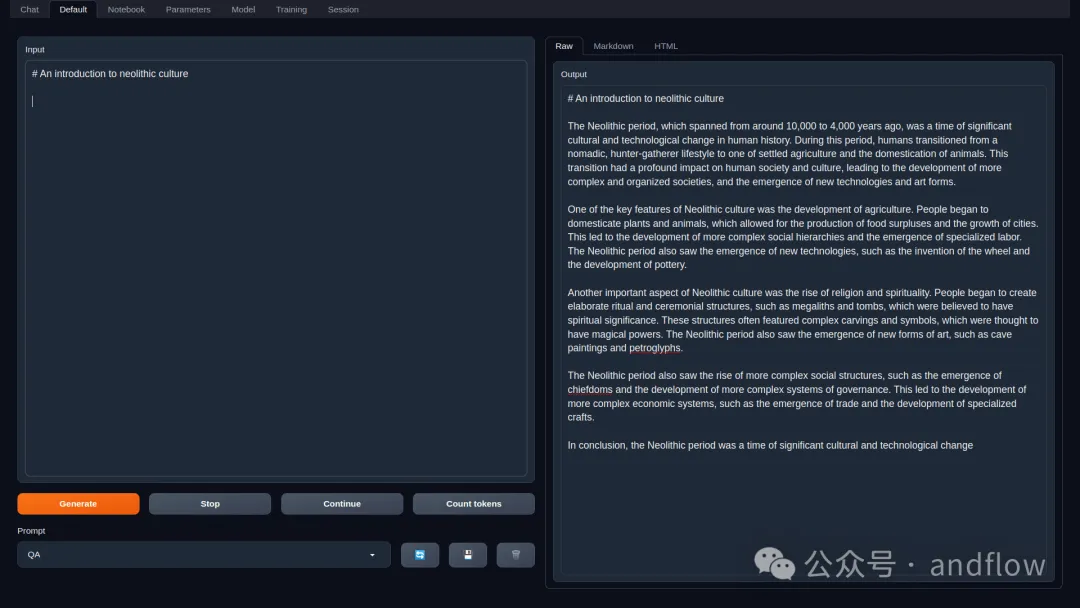

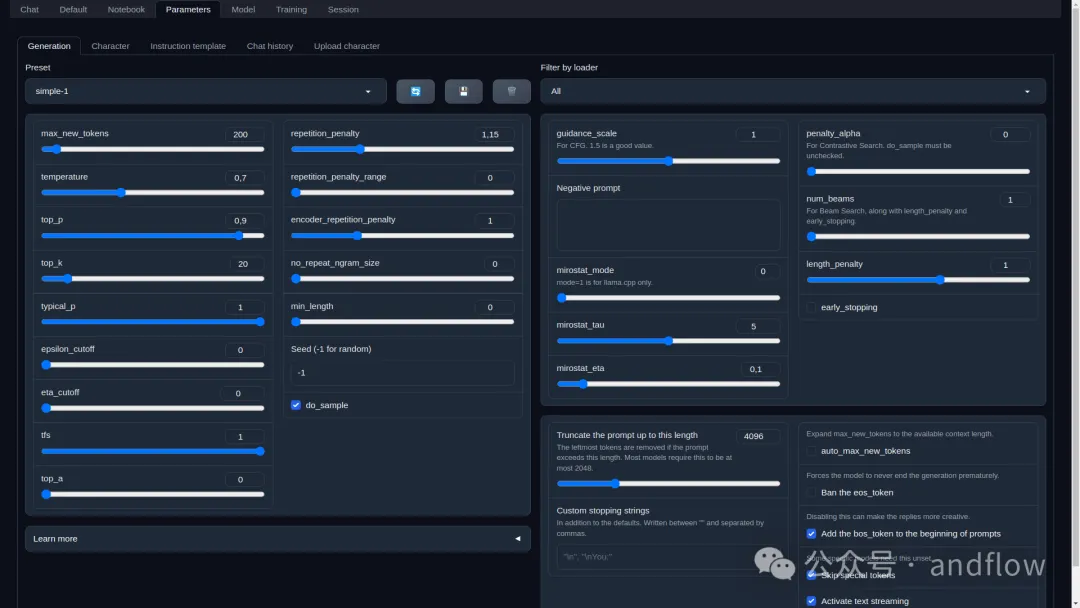

2.Text Generation Webui

https://github.com/oobabooga/text-generation-webui

Star:40.5K

开发语言:Python

这是一个基于Gradio的Web UI,用于大语言模型的Web层。

产品特性:

在一个UI以及API中支持多个文本生成的后端,包括:Transformers、llama.cpp、ExLlamaV2、TensorRT-LLM、AutoGPTQ、AutoAWQ、HQQ、 AQLMare等

兼容OpenAI的API。

使用Jinja2模板自动提示格式化。

三种聊天模式:instruct、chat-instruct、chat,其中chat-instruct有自动提示模板。

可在“聊天记录”菜单之间的对话快速切换。

在默认、笔记本选项卡中生成自由格式的文本,而不限于聊天回合。

拥有多个采样参数和生成选项,用于支持复杂的文本生成控制。

在UI中轻松切换不同型号,无需重新启动。

简单的LoRA微调工具。

安装在一个独立的installer_files目录中,不会影响系统环境。

扩展支持,提供许多内置的或者用户贡献的扩展。

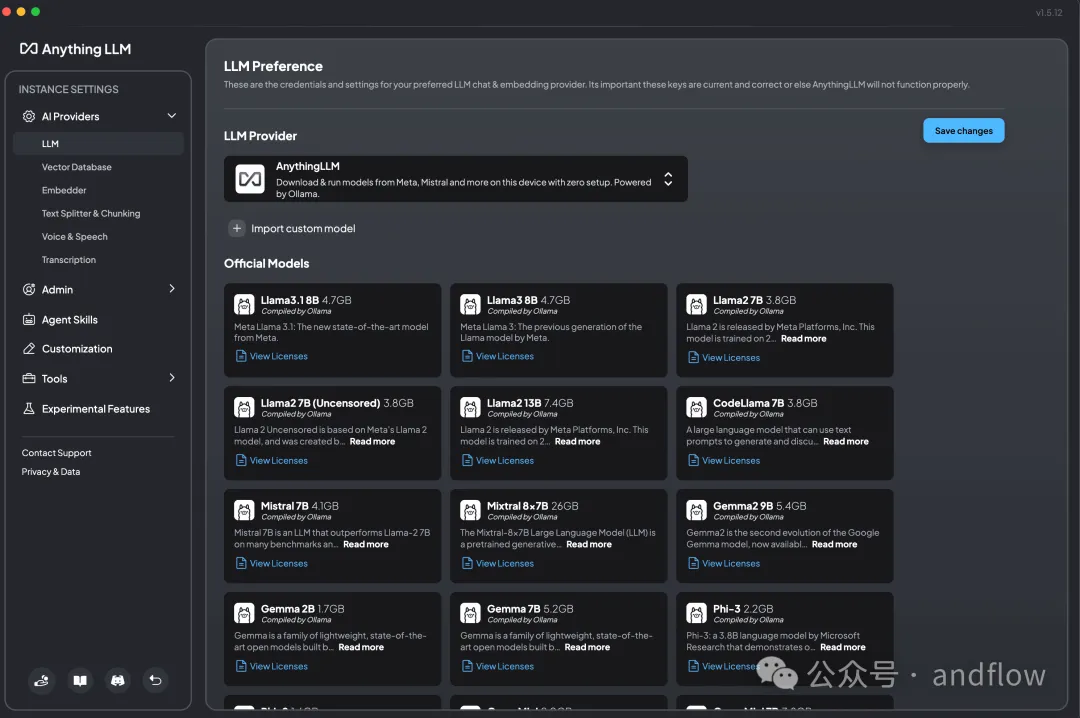

3.Anything LLM

https://github.com/Mintplex-Labs/anything-llm

Star:26.5K

开发语言:JavaScript

AnythingLLM是一个多功能的全栈AI应用程序,可以在与大型语言模型(LLM)聊天期间引用自己的文档或内容作为上下文数据。它专为易用性而设计,提供了一个高度可配置的多用户环境。用户可以选择集成商业的或者开源的LLM,选择向量数据库,并管理访问权限。

该应用程序将文档组织到“工作区”中,这些工作区是容器化的单元,可以在不同的线程之间保持上下文的隔离。

工作区可以共享文档,但也能够为一些重点对话维护隔离的上下文。AnythingLLM可运行在Mac、Windows或者Linux桌面系统上,支持本地或远程执行,使其成为构建自定义、私人ChatGPT的强大工具。

产品特征:

支持AI Agent定义

支持多种模型(包括封闭和开源LLM!)

支持多用户实例和Docker版本

可在工作空间内安装代理(浏览网页、运行代码等)

提供适用于嵌入网站的聊天组件

支持多种文档类型(PDF,TXT,DOCX等)

简单的聊天用户界面、拖放功能和明确的使用指南。

支持100%云部署。

可以与所有流行的闭源和开源LLM提供商对接。

与其他聊天界面相比,可以用于管理非常大的文档。

提供用于自定义集成的API

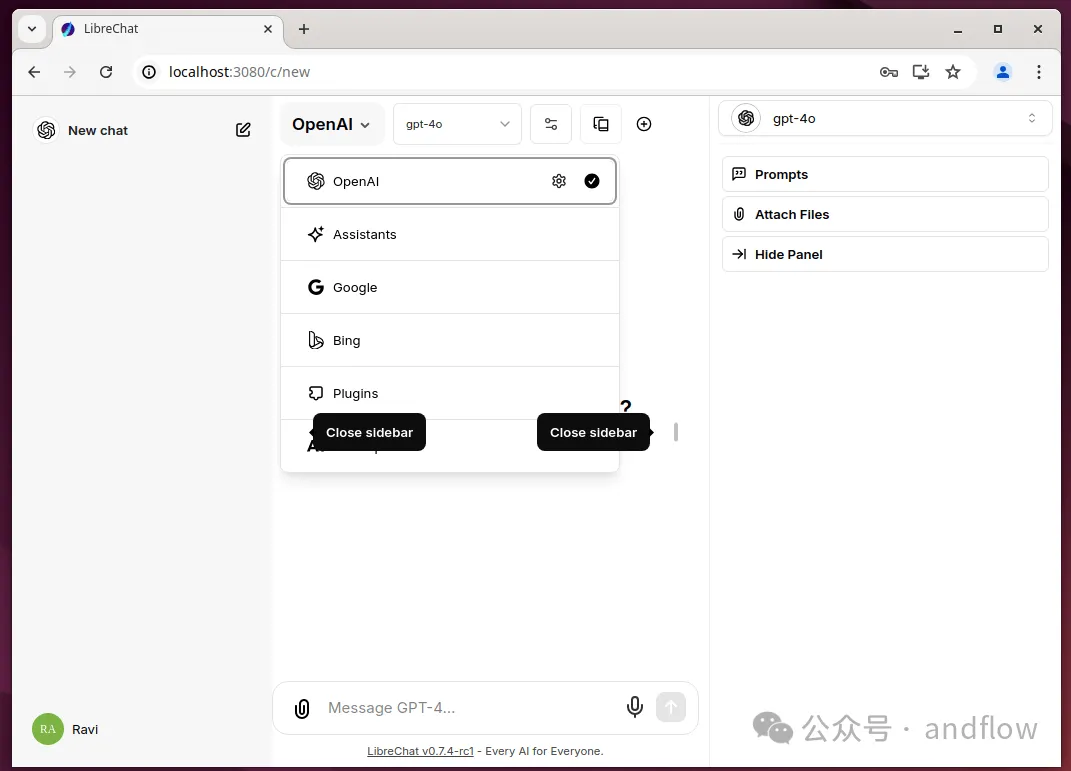

4.LibreChat

https://github.com/danny-avila/LibreChat

Star:18.9K

开发语言:TypeScript、JavaScript

LibreChat可以作为ChatGPT的私人替代品,在您自己的服务器上运行。

产品特征:

支持与ChatGPT匹配的UI,包括Dark模式、Streaming和最新更新

智能选型:Anthropic(Claude),AWS Bedrock,OpenAI,Azure OpenAI,BingAI,ChatGPT,Google Vertex AI,插件,助手API(包括Azure助手)

两者兼容远程和本地AI服务:Groq、Ollama、Cohere、Mistral AI、Apple MLX、koboldcpp、OpenRouter、together.ai、Perplexity、ShuttleAI等

生成式UI,代码工件:在聊天中创建React、HTML代码和Mermaid图表

创建、保存和共享自定义预设

在AI端点和预设之间切换,聊天中

使用对话分支编辑、重新提交和继续消息

用于高级上下文控制的会话

多模式聊天:可通过OpenAI Assistant API️;非OpenAI代理在积极开发中;使用Claude 3、GPT-4(包括gpt-4o和gpt-4o-mini)和Gemini Vision软件上传和分析图像;使用自定义端点,OpenAI,Azure,Anthropic,Google与文件聊天。🗃️;具有文件、代码解释器、工具和API操作的高级代理🔦

多语言用户界面:English,中文,Deutsch,Español,Français,意大利语,Polski,巴西葡萄牙语;Русский, 日本語, Svenska, 한국어, Tiếng Việt, 繁體中文, العربية, Türkçe, Nederlands, עברית

可定制的下拉界面:适应高级用户和新手

验证您的电子邮件以确保安全访问

语音到文本和文本到语音的魔术免提聊天:自动发送和播放音频;支持OpenAI、Azure OpenAI和Elevenlabs

从LibreChat,ChatGPT,Chatbot UI导入对话

导出对话为截图,markdown,文本,json

搜索所有消息/对话

插件,包括Web访问、使用DALL-E-3生成图像等

使用审核和令牌支出工具的多用户安全身份验证

️配置代理,反向代理,Docker,和许多部署选项:完全本地使用或部署在云上

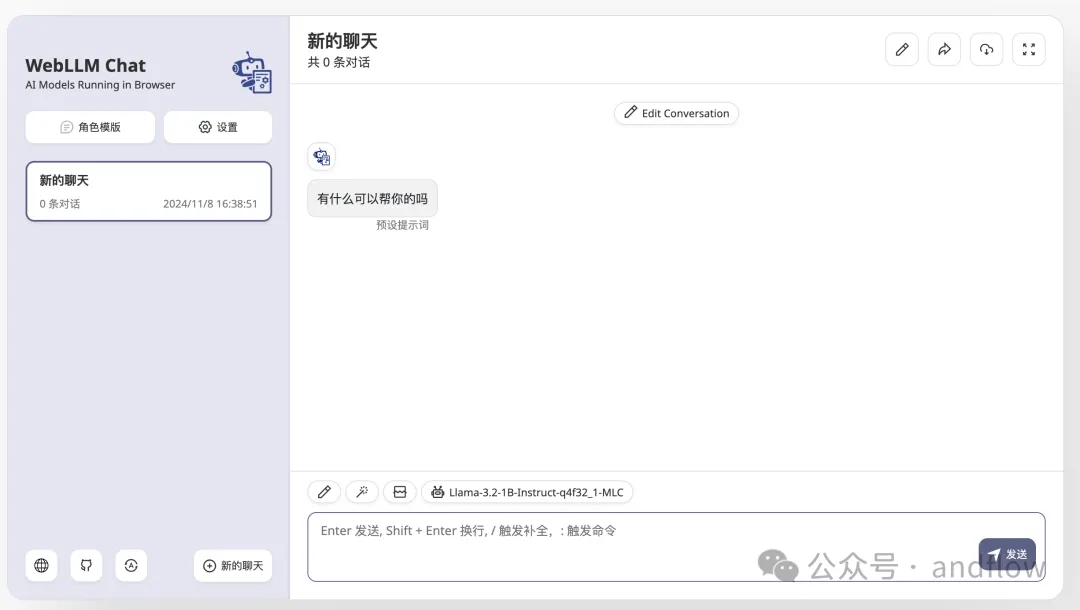

5.Web LLM

https://github.com/mlc-ai/web-llm

Star:13.6K

开发语言:TypeScript

WebLLM是一个高性能的浏览器内LLM推理引擎,通过硬件加速将语言模型推理直接带到Web浏览器上。一切都在浏览器内运行,没有服务器支持,并通过WebGPU加速。WebLLM完全兼容OpenAI API。也就是说,可以在本地任何开源模型上使用相同的OpenAI API,其功能包括流式传输,JSON模式,函数调用(function-calling,简写)等。

产品特征:

浏览器内推理:WebLLM是一个高性能的浏览器内语言模型推理引擎,它利用WebGPU进行硬件加速,直接在Web浏览器内实现强大的LLM操作,而无需服务器端处理。

兼容OpenAI API:使用OpenAI API将您的应用与WebLLM无缝集成,并提供流、JSON模式、logit级别控制、种子等功能。

结构化JSON生成:WebLLM支持最先进的JSON模式结构化生成,在模型库的WebAssembly部分实现,以获得最佳性能。检查HuggingFace上的WebLLM JSON Playground,尝试使用自定义JSON模式生成JSON输出。

丰富的模型支持:WebLLM支持一系列原生大模型,包括:Llama 3,Phi 3,Gemma,Mistral,Qwen(通义问)等,使其成为各种AI任务的通用工具。有关完整的支持型号列表,请选中模型。

自定义模型集成:轻松集成和部署MLC格式的自定义模型,使您能够根据特定需求和场景调整WebLLM,增强模型部署的灵活性。

即插即用集成:使用NPM和Yarn等包管理器或直接通过CDN将WebLLM轻松集成到您的项目中,并提供全面的示例和用于连接UI组件的模块化设计。

流式传输与实时交互:支持流式聊天完成,允许实时输出生成,增强了聊天机器人和虚拟助手等交互式应用程序。

支持Web Worker& Service Worker:通过将计算卸载到独立的工作线程或服务工作线程,优化UI性能并有效管理模型的生命周期。

支持Chrome扩展:使用WebLLM通过自定义Chrome扩展程序扩展Web浏览器的功能,并提供构建基本和高级扩展程序的示例。

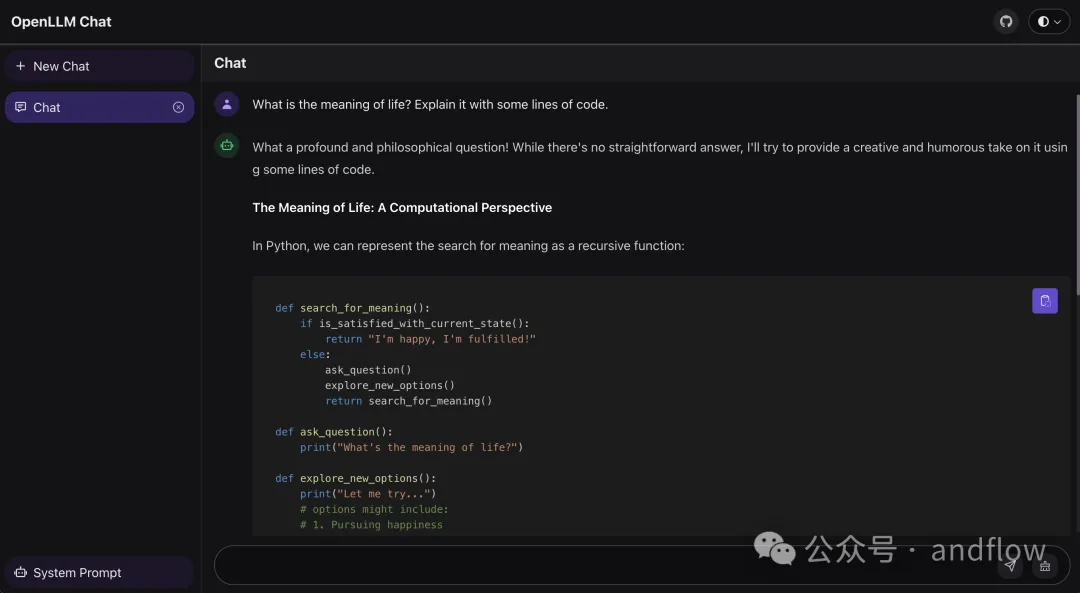

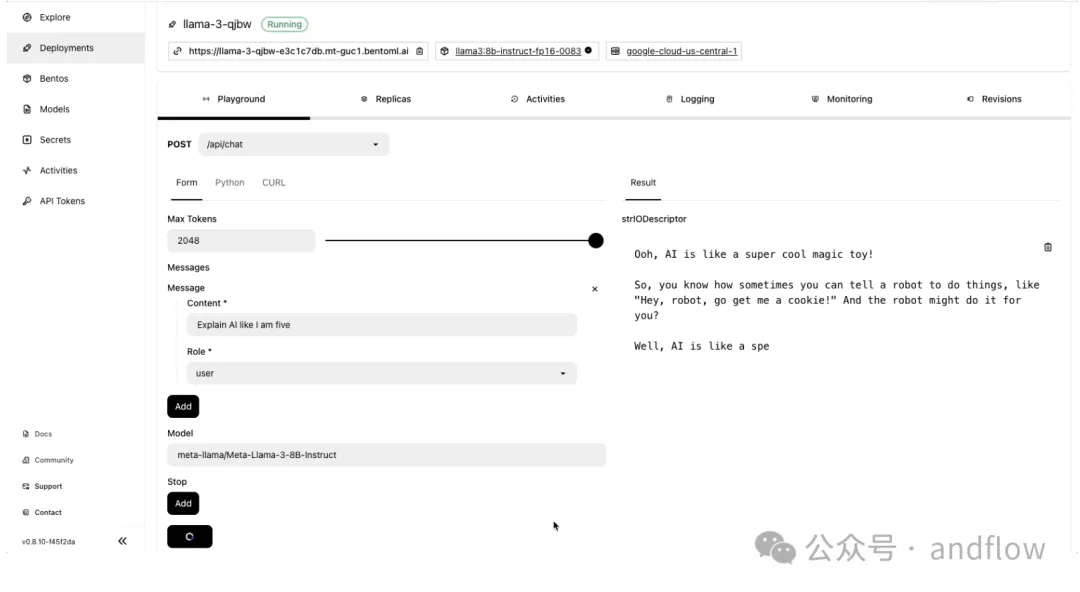

6.OpenLLM

https://github.com/bentoml/OpenLLM

Star:10K

开发语言:Python

OpenLLM是一个可以在云中运行开源大语言模型(LLM)的工具,如:Llama,Qwen和Phi等,也可以兼容OpenAI的API接入。它支持使用Docker、Kubernetes和BentoCloud简化模型的部署过程。

OpenLLM支持多种模型,并提供友好的用户界面,提供内置的聊天UI。它还可以与BentoML集成,用于企业级AI推理和部署。此外,用户可以将模型贡献到其存储库中,或者在自己的基础设施上部署自定义模型。

使用以下命令进行安装:

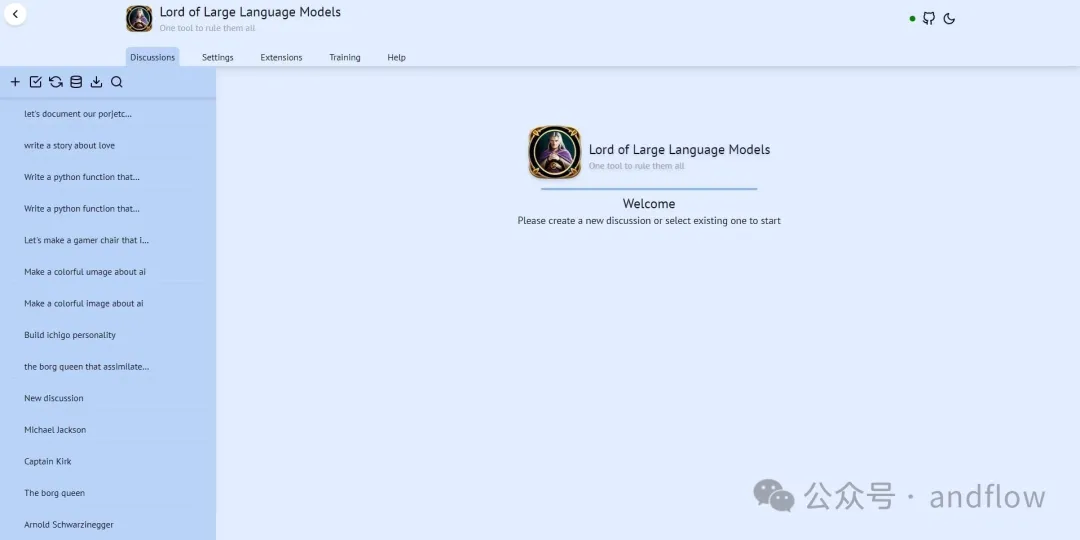

7.LoLLMs

https://github.com/ParisNeo/lollms-webui

Star:4.3K

开发语言:JavaScript/Vue 、Python

LoLLMS WebUI(Lord of Large Language Multimodal Systems)是一个多功能一体化平台,可访问各种任务类型的AI模型,例如:写作、编码、图像生成、音乐创作等。它支持500多个专家模型和2500个跨不同领域的微调模型。

用户可以选择根据特定需求量身定制的模型,无论是编码帮助、医疗建议、法律的指导、创意故事还是娱乐。

该平台的设计考虑到了易用性,提供了一个友好的用户界面,具有明亮和暗黑模式。LoLLMS可以用于实现增强电子邮件、代码调试、解决问题,甚至提供如笑声机器人、创意故事生成器、和个性化音乐生成之类的有趣功能。

它将生产力工具和娱乐结合在一个界面中,使其成为满足各种专业需求的多功能工具。

产品特征:

为您的任务选择您喜欢模型和个性化配置

增强您的电子邮件、论文、代码调试、思想组织等

探索各种功能,如:搜索、数据组织、图像生成和音乐生成

易于使用的用户界面,具有亮暗模式选项

与GitHub存储库集成,便于访问

可自定义向导信息

生成的答案的拇指向上/向下评级

复制、编辑和删除邮件

用于讨论的本地数据库存储

搜索、导出和删除多个讨论

支持基于稳定扩散的图像/视频生成

支持基于musicgen的音乐生成

通过Lollms节点和花瓣支持多代对等网络。

支持Docker、conda和手动虚拟环境设置

支持LM Studio作为后端

支持Ollama作为后端

支持vllm作为后端

支持根据任务快速路由到对应的模型

还没有评论,来说两句吧...