视觉语言模型(如 GPT-4o、DALL-E 3)通常拥有数十亿参数,且模型权重不公开,使得传统的白盒优化方法(如反向传播)难以实施。

那么,有没有更轻松的优化方法呢?

就在最近,卡内基梅隆大学(CMU)的研究团队对于这个问题提出了一种创新的“黑盒优化”策略——

通过大语言模型自动调整自然语言提示词,使视觉语言模型在文生图、视觉识别等多个下游任务中获得更好的表现。

这一方法不仅无需触及模型内部参数,还大幅提升了优化的灵活性与速度,让用户即使没有技术背景也能轻松提升模型性能。

该研究已被 CVPR 2024 接收。

如何做到的?

大多数视觉语言模型(如 DALL-E 3、GPT-4o 等)并未公开模型权重或特征嵌入,导致传统依赖反向传播的优化方式不再适用。

不过,这些模型通常向用户开放了自然语言接口,使得通过优化提示词来提升模型表现成为可能。

然而,传统的提示词工程严重依赖工程师的经验和先验知识。

例如,为提升 CLIP 模型的视觉识别效果,OpenAI 花费了一年时间收集了几十种有效的提示词模板(如 “A good photo of a [class]”)。

同样,在使用DALL-E 3和Stable Diffusion等文生图模型时,用户往往也需掌握大量提示词技巧才能生成满意的结果。

那么,有没有替代人类提示词工程师的方法?

有的 CMU 团队提出了一种新策略:用 ChatGPT 等大语言模型自动优化提示词。

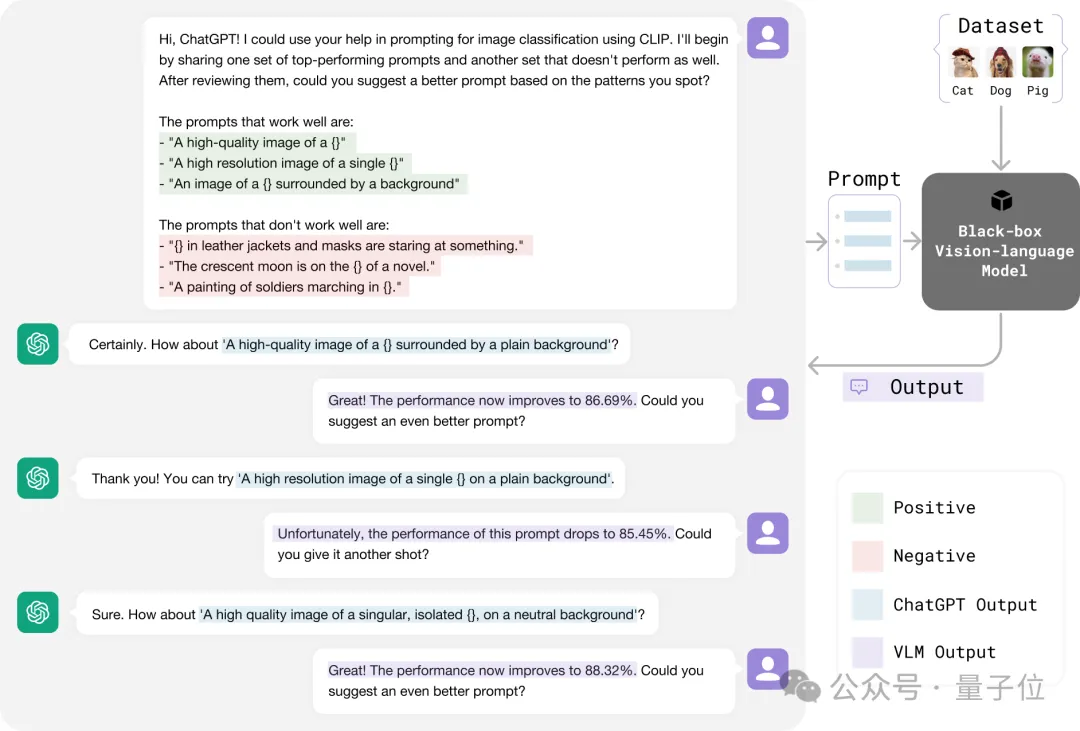

像提示词工程师利用反馈改进提示词一样,CMU 的方法将正负反馈交给 ChatGPT,以更高效地调整提示词,具体过程如图所示:

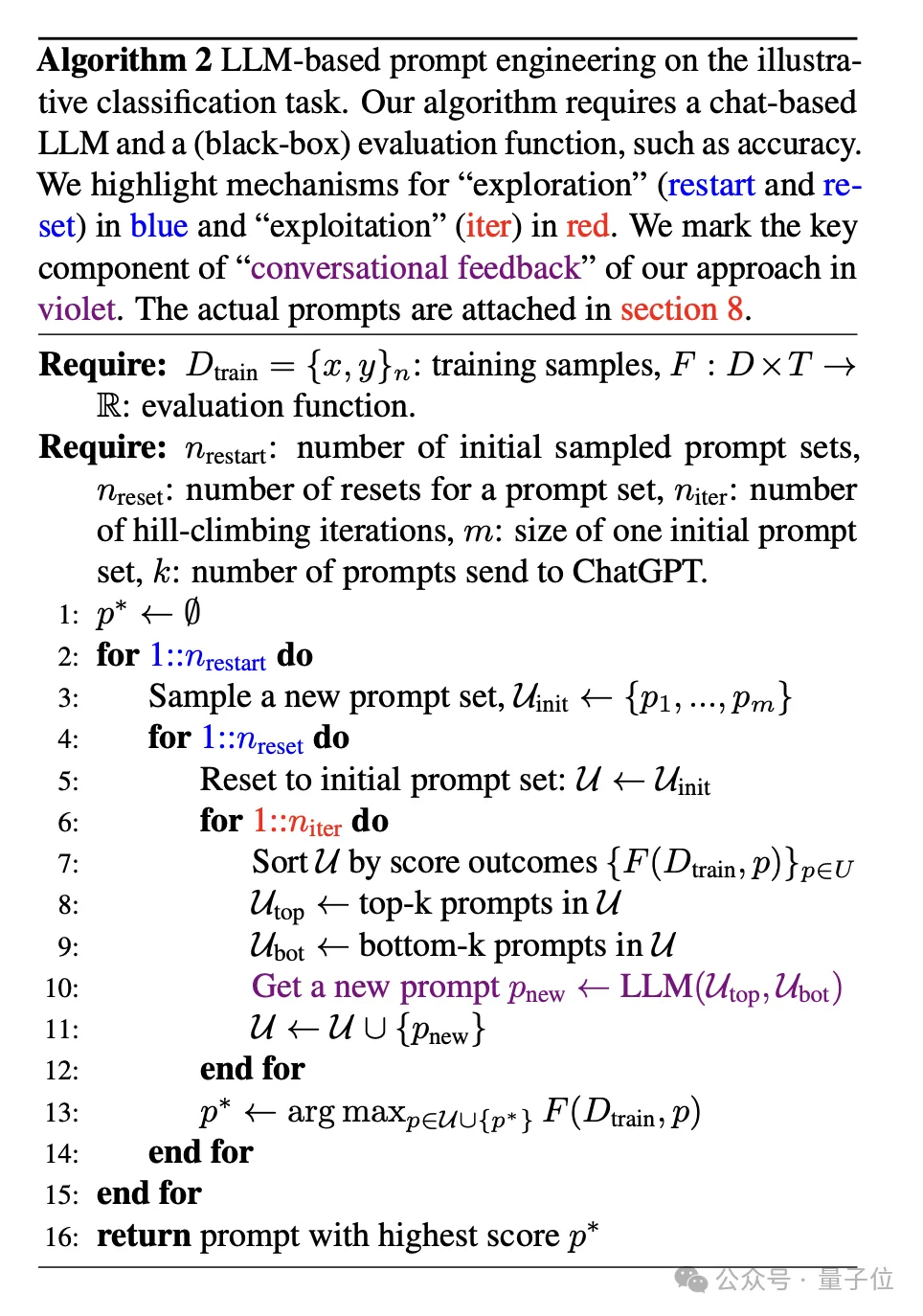

这种优化过程类似于机器学习中的“爬山法”(hill-climbing)策略,不同之处在于大语言模型可以自动分析提示词表现,从正负反馈中找到最优改进方向。

研究团队利用这一特性来更高效地优化提示词。这个过程可以用以下步骤概括:

提示词初始化:收集一批未经优化的初始提示词。

提示词排序:对当前提示词进行表现评分,保留高分提示词,替换低分提示词。

生成新提示词:通过大语言模型,根据提示词的表现生成新的候选提示词。

经过多轮迭代,最终返回得分最高的提示词作为优化结果。

实验结果

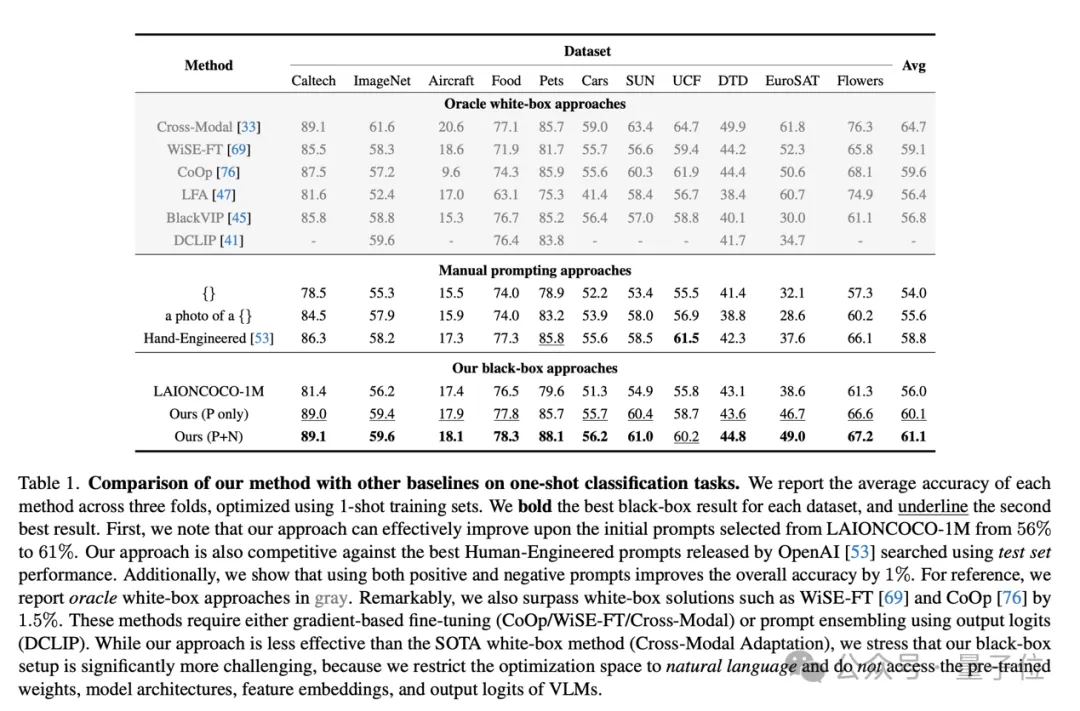

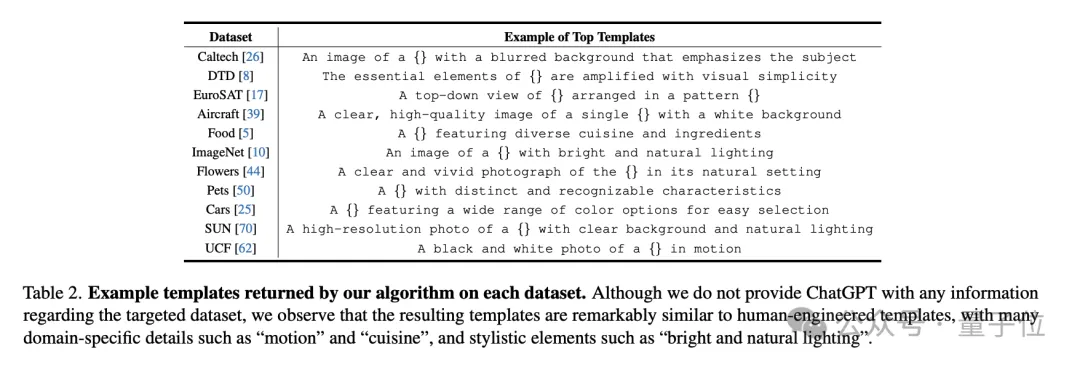

通过这一方法,CMU 团队在无需人类提示工程师参与的情况下,在多个小样本视觉识别数据集上取得了最佳准确性,甚至超越了传统的白盒提示词优化方法(如 CoOp)。

此外,该方法在无需了解数据集内容的前提下,自动捕捉到了下游任务的视觉特性并将其融入提示词中,取得了更好的效果。

例如,在食物识别任务中,ChatGPT 自动将提示词调整为识别“多样化的美食和原料”,从而提升了模型的表现。

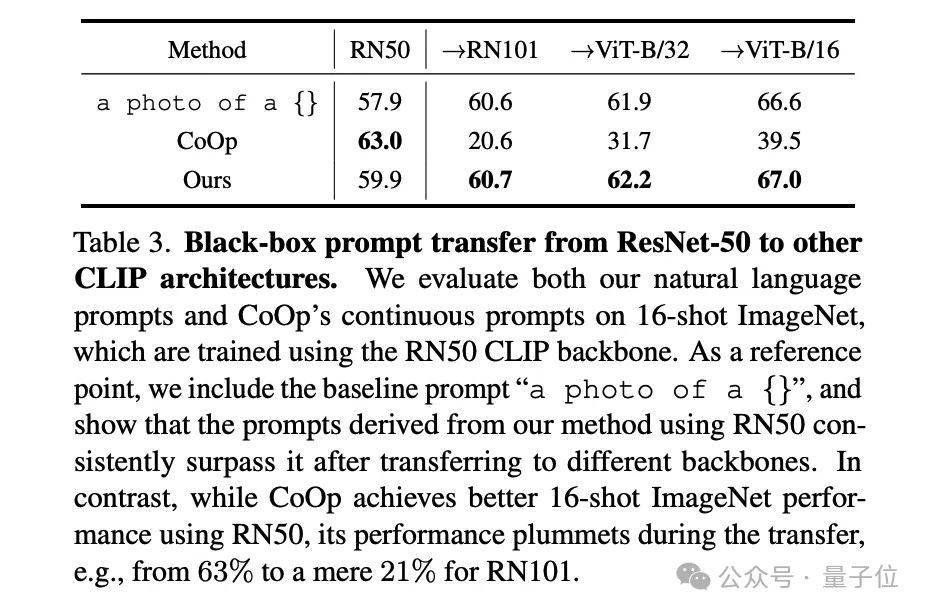

研究团队还证明了,通过 ChatGPT 黑盒优化得到的提示词不仅适用于单一模型架构,还能在不同模型架构(如 ResNet 和 ViT)之间泛化,并且在多种模型上表现优于白盒优化得到的提示词。

这一系列实验证明,大语言模型能够从提示词的性能反馈中提取出隐含的“梯度”方向,从而实现无需反向传播的模型优化。

在文生图任务中的应用

CMU 团队进一步探索了该方法在生成任务中的应用潜力。

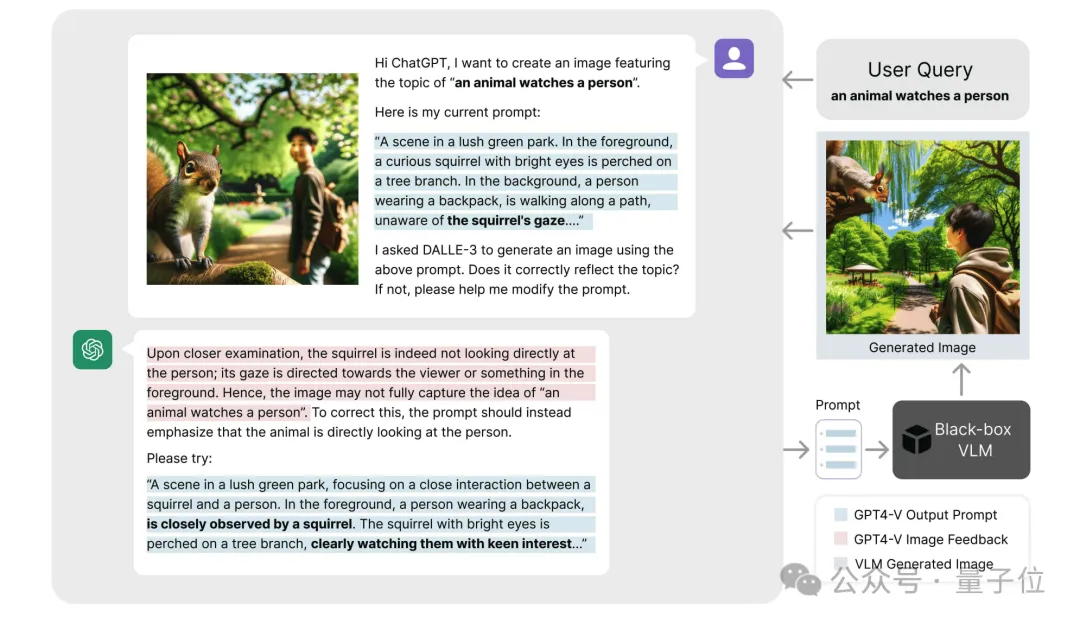

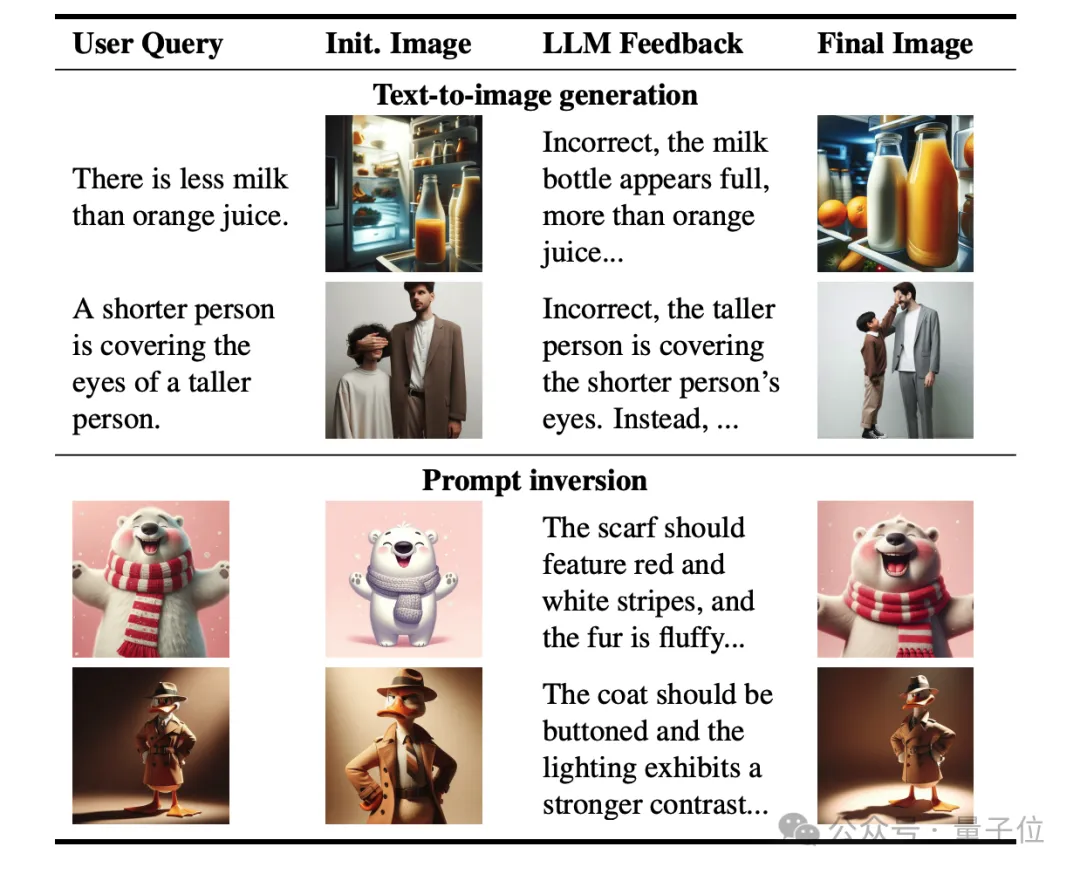

在文本到图像生成(T2I)任务中,ChatGPT 能够自动优化提示词,从而生成更符合用户需求的高质量图像。

例如,对于输入描述“一个动物注视着一个人”,系统可以通过逐步优化提示词来提升生成图像的准确性。

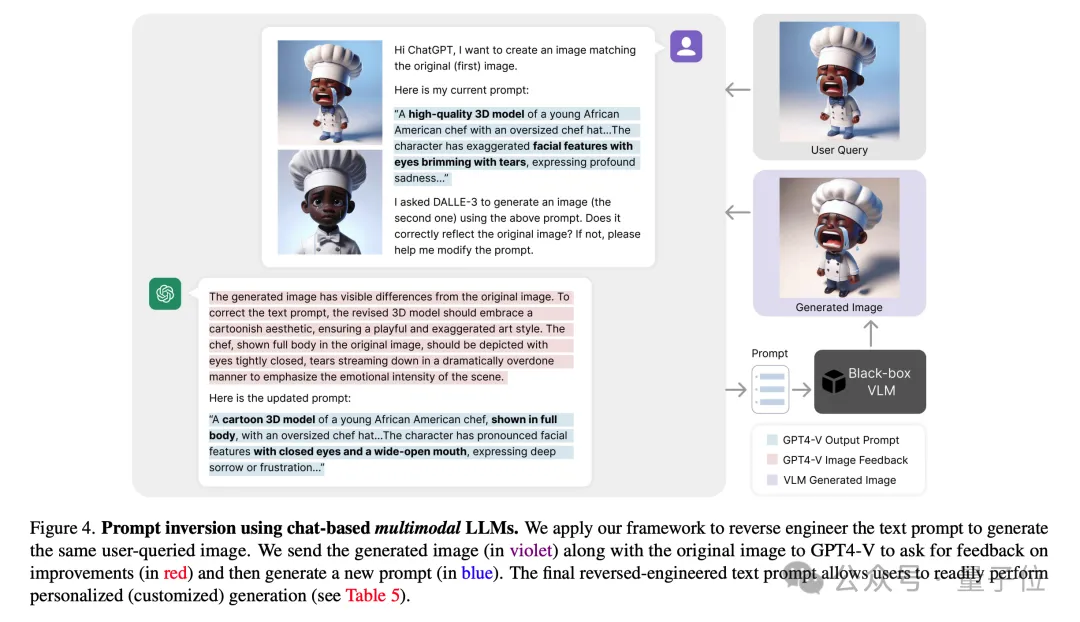

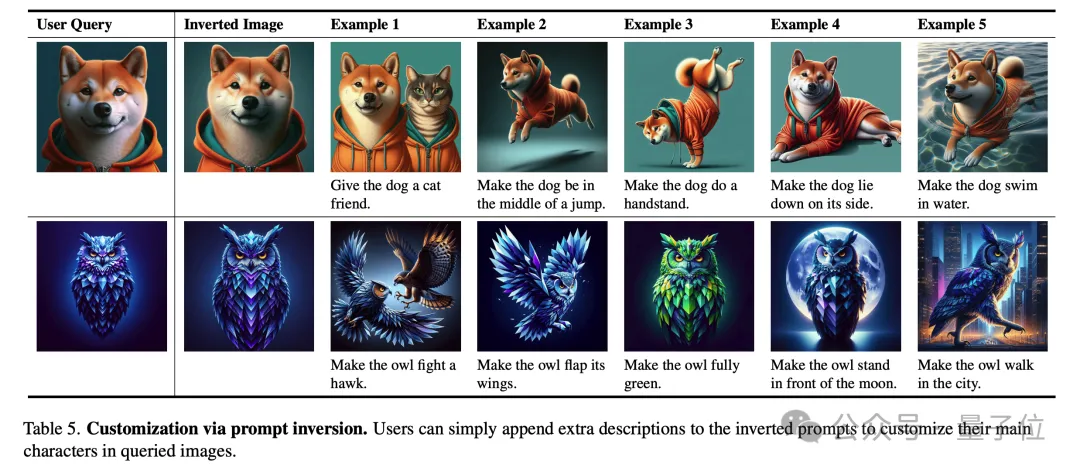

此外,这一方法还适用于提示反演(Prompt Inversion)。

提示反演是一种根据现有图像反推生成模型输入提示词的技术,简单来说,就是通过图像生成能够再现其特征的文本描述(提示词)。

研究团队在复杂的文本到图像任务上进行了测试,结果表明这一方法仅需三轮提示词优化,就能显著提高用户的满意度。

此外,研究团队还指出,提示反演可以帮助用户快速定制特定的图像效果,例如“让这只狗变成站立姿势”或“让背景变成夜景”,从而生成符合特定需求的图像。

CMU 团队表示,提出的黑盒优化范式突破了传统模型调优的限制,不仅在图像分类和生成任务中表现出色,还展示了广泛的应用潜力。

这一方法无需访问模型权重,仅通过“文本梯度”实现精准优化,具备强大的扩展性。

未来,黑盒优化有望应用于实时监控、自动驾驶、智能医疗等复杂动态场景,为多模态模型的调优带来更加灵活高效的解决方案。

团队介绍

团队的一作刘士弘(Shihong Liu)是卡内基梅隆大学的研究生毕业生,曾任机器人研究所研究员。

目前在 北美Amazon 工作,负责大型分布式系统的计算和大语言模型驱动的 AI Agent 的开发。

△刘士弘(Shihong Liu)

团队的共同一作林之秋(Zhiqiu Lin)是卡内基梅隆大学的博士研究生,专注于视觉-语言大模型的自动评估与优化。

Zhiqiu Lin在CVPR、NeurIPS、ICML、ECCV等顶级会议上发表了十数篇论文,并曾荣获最佳论文提名和最佳短论文奖等。

△林之秋(Zhiqiu Lin)

Deva Ramanan教授是计算机视觉领域的国际知名学者,现任卡内基梅隆大学教授。

△Deva Ramanan教授

他的研究涵盖计算机视觉、机器学习和人工智能领域,曾获得多项顶级学术荣誉,包括2009年的David Marr奖、2010年的PASCAL VOC终身成就奖、2012年的IEEE PAMI青年研究员奖、2012年《大众科学》评选的“十位杰出科学家”之一、2013年美国国家科学院Kavli Fellow、2018年和2024年的Longuet-Higgins奖,以及因其代表性工作(如COCO数据集)获得的Koenderink奖。

此外,他的论文在CVPR、ECCV和ICCV上多次获得最佳论文提名及荣誉奖。他的研究成果对视觉识别、自动驾驶、和人机交互等应用产生了深远影响,是该领域极具影响力的科学家之一。

CVPR’24论文链接: https://arxiv.org/abs/2309.05950

论文代码: https://github.com/shihongl1998/LLM-as-a-blackbox-optimizer

项目网站: https://llm-can-optimize-vlm.github.io

还没有评论,来说两句吧...