Sora、Luma等模型留给业界惊艳的同时,也甩给了无数后期剪辑的噩梦:好好的一个人物,动不动脸部就变形了,这魔法有点离谱,有时候,不可控就意味着不可用。

就好比之前小编用Luma,生成一段“牛顿被苹果砸着头”视频,苹果树下的牛顿,远景和特写咋看都是两个人。

难怪有人说让AI生成一张合适的人物表情,简直就需要“欧皇”的运气,抽到SSS卡才行。

1.首个可控人物视频生成大模型Vimi厉害在哪里?

而就在今天,商汤科技做到了!商汤发布了业内首个“可控”人物视频生成大模型产品Vimi。毫不夸张的说,视频制作者的福音来了!

想一想1分钟稳定的单镜头人物特写镜头,画面效果不会随着时间的变化而劣化或失真,这将省去多大的工作量!

更令人兴奋的是,还可以随心控制表情和肢体,这将是怎样的效率突破!

7月4日,世界人工智能大会开幕。在上海这座创新之城,商汤直接抛出一个炸裂的发布:首个面向C端用户的可控人物视频生成大模型Vimi惊艳亮相。

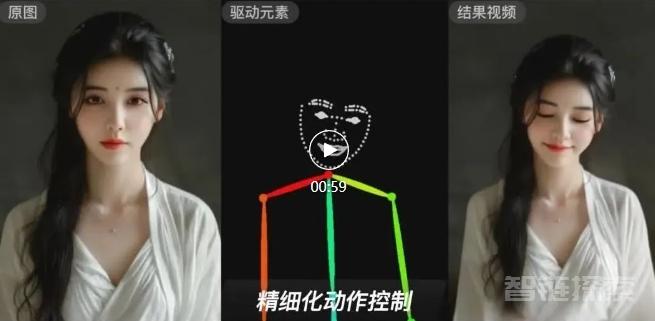

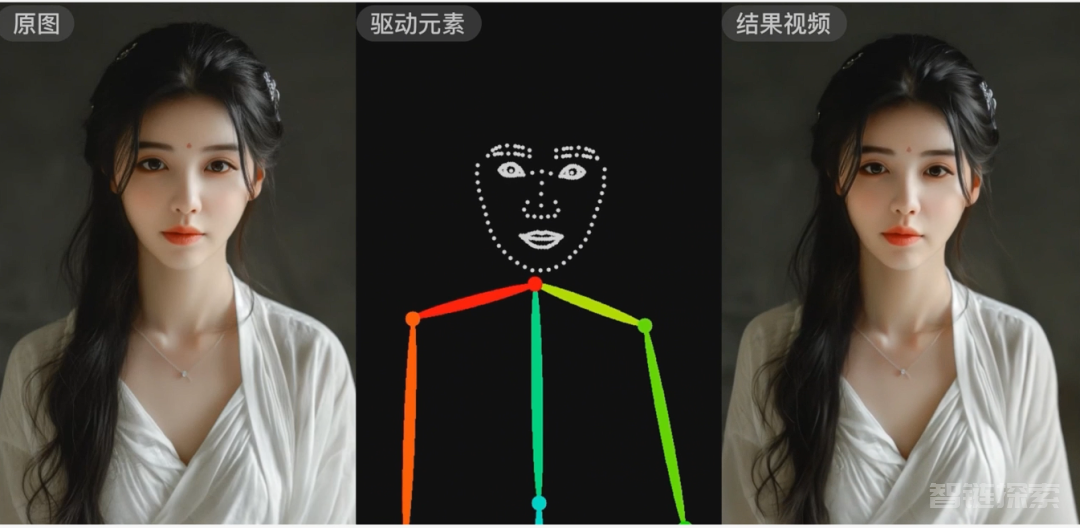

据悉,该模型主要面向C端用户。根据现场展示来看,难得之处就在于,Vimi能够实现精准的人物表情控制,同时还可实现在半身区域内控制照片中人物的自然肢体变化,并自动生成与人物相符的头发、服饰及背景变化,可稳定生成1分钟的单镜头人物类视频。

图片

图片

也可以让你喜欢的人物角色为你奉上一场“表情大赏”。

这还没完,除了生成你想要的动态表情包,还可以为人物配上相应的服饰、配饰和背景,看起来毫无违和感。

当然了,根据照片,可快速生成写真视频,这一点也自然能轻松做到了。吐槽:妙鸭相机要有压力了~

图片

图片

据悉Vimi将完全面向C端用户开放使用,到时候聊天、唱歌、舞动等多种娱乐互动场景相信都能看到Vimi的身影。

不过,现在处于内测阶段,小编第一时间也申请了,目前还在焦急等待中。

2.写在最后

总结下,Vimi有以下四大特点:

1、人物可控性:可控生成高一致性的人物表情及肢体动作视频。

2、多种控制方式:可以通过人物视频、动画参数、语音文字等输入驱动。

3、分钟级单镜头:支持生成分钟级的单镜头人物视频,在演示的视频中,可以看到视频长达1分钟。

4、生成合理的视频场景:支持人物合理的头发、服饰、背景补全,并支持光影变化。

整体上看,通过一张任意风格的照片就能生成和目标动作一致不随时间变化而失真的人物类视频,可通过已有人物视频、动画、声音、文字等多种元素进行驱动,足够在人物方面把Luma比下去了,毕竟各有所长。

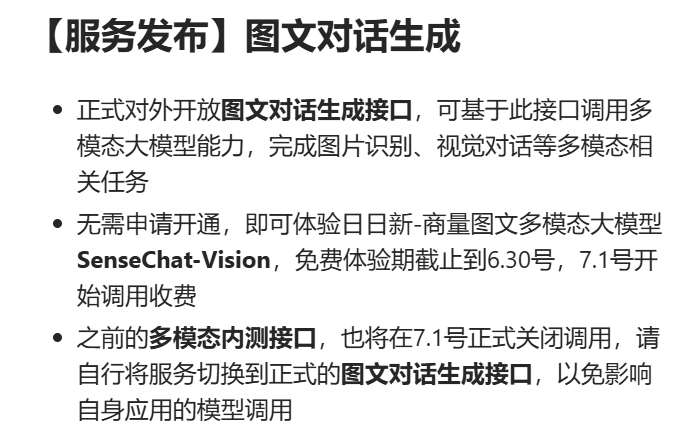

至于Vimi为什么这么厉害?当然还是底座模型太给力了,商汤日日新大模型SenseNova,猜测是图文多模态大模型SenseChat-Vision的加持,不过免费体验期已经截止了。

图片

图片

忘了,上个内测申请链接:https://www.wjx.cn/vm/mhSxfGv.aspx

还没有评论,来说两句吧...