让ChatGPT准确回答来自证券交易委员会文件的复杂问题,可谓是到处都是坑。

先进人工智能模型的出现彻底改变了自然语言处理领域,使机器能够以越来越高的准确性和复杂性来分析、解释和响应人类语言。

然而,尽管这些模型取得了重大进步,但一些人工智能助手(例如 ChatGPT)在准确回答来自证券交易委员会文件的复杂问题方面仍然面临挑战。

Patronus AI的研究人员发现,即使是性能最好的 AI 模型配置 OpenAI 的 GPT-4-Turbo,在 Patronus AI 的新测试中也只能正确回答 79% 的问题。

1、Redis与 LangChain 合作

图片

图片

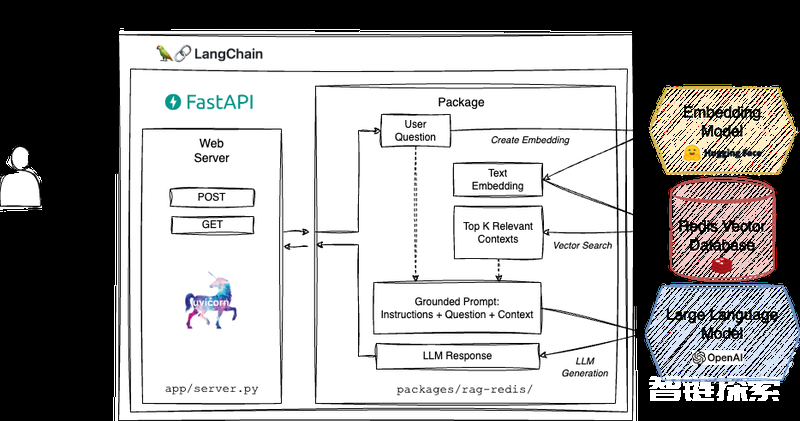

Redis与LangChain合作开发出了Redis RAG模板,该模板经过优化,可创建事实一致的LLM聊天应用程序。通过利用Redis作为向量数据库,该模板确保了快速的上下文检索和有根据的提示构建,使其成为开发人员创建聊天应用程序的关键工具,提供响应和精确的人工智能响应。

图片

图片

Redis RAG 模板是一个 REST API,允许开发人员与公共财务文档(例如 Nike 的 10k 文件)进行交互。该应用程序使用 FastAPI 和Uvicorn通过 HTTP 处理客户端请求。它还使用 UnstructedFileLoader 将 PDF 文档解析为原始文本,使用 RecursiveCharacterTextSplitter 将文本分割成更小的块,并使用 HuggingFace 中的“all-MiniLM-L6-v2”句子转换器将文本块嵌入到向量中。此外,它利用 Redis 作为实时上下文检索的向量数据库,并利用 OpenAI“gpt-3.5-turbo-16k”LLM 来生成用户查询的答案。

在最近与AIM的互动中,Redis 首席技术官Yiftach Shoolman表示:“你的数据无处不在,在笔记本电脑上,在 AWS s3 上的组织存储库上,在 Google 云存储上,等等。你需要一个平台将数据导入像 Redis 这样的向量数据库中,根据相关知识来进行分割”。

2、ChatGPT需要外挂

Shoolman在批评ChatGPT时,他说:“ChatGPT 不知道任何事情,因为它没有接受你的数据训练,并补充说用户需要在他们刚刚创建的知识库中查找与其请求相关的数据。

RAG模板提供了可部署的参考架构,将效率与适应性融为一体,为开发人员提供了一套全面的选项,以创建事实一致、由法学硕士支持的聊天应用程序,并具有快速响应和精确的 AI 响应。

LangChain的可部署体系结构中心还包括特定于工具的链、LLM链和特定于技术的链,这些链减少了部署API时的摩擦。

图片

图片

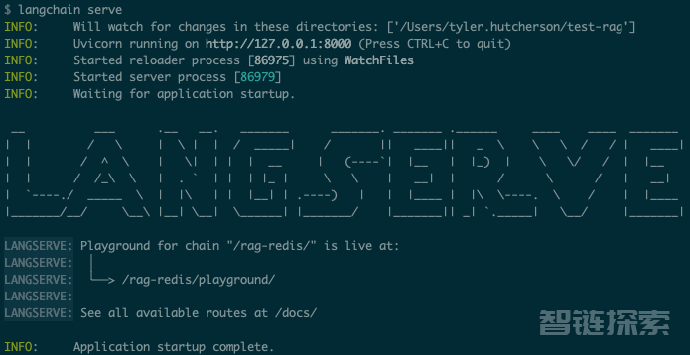

其中,LangServe是部署这些模板的核心,它使用FastAPI将基于LLM的链或代理转换为可操作的REST API,增强可访问性,并为生产做好准备。

原文链接:

https://analyticsindiamag.com/ai-models-revolutionised-the-field-of-natural-language-processing/

还没有评论,来说两句吧...